Newsletter

11 de junio, 2019

AWS Azure big data Cloudera Google Hadoop Hortoworks John Schroeder MapR Tom Reilly

Las fusiones corporativas que buscan exclusivamente ganar escala como factor competitivo no siempre dan los resultados esperados. Me atrevería a sugerir que, cuando con el tiempo se echan las cuentas (si es que se echan y se publican), muchas habrán salido mal. Estoy ahora mismo pensando en Cloudera, una empresa que tuve varias ocasiones de conocer y que en enero completó la adquisición de Hortonworks por la bonita suma de 5.200 millones de dólares. Se suponía que juntas estarían en mejores condiciones de salir adelante en un mercado que estaba cambiando.

El caso es que la nueva Cloudera ha presentado unos pésimos resultados del primer trimestre cerrado tras la integración. Sobre unos ingresos de 188 millones de dólares, ha sufrido unas pérdidas netas de 103,7 millones. Esto ha tenido dos consecuencias inmediatas: la cotización se hundió un 40% y su CEO Tom Reilly, que concibió y llevó a término la fusión, abandonará la empresa a finales de julio sin que siquiera se le haya buscado sucesor.

Ante los analistas, Reilly se ha declarado sorprendido por el “viento en contra”. Las órdenes de pedido han caído – dijo sin dar cifras que permitan compararlas – y la combinación no ha sido entendida por los clientes de las dos compañías fusionadas. Pero es que, además, el intento de ampliar el modelo de negocio lanzando una nueva plataforma, ha sido recibido con escepticismo, que de momento se traduce en la parálisis de renovaciones de contratos de servicios.

Si estos fueran los problemas, podrían verse como errores tácticos corregibles. Mi impresión es que la desgracia de Cloudera está indicando algo más profundo: el espacio del mercado llamado data analytics se está transformando por la voracidad de una nueva especie predadora que ha dado en llamarse hyperscalers. Los tres colosos que dominan el mercado de la infraestructura como servicio están “naturalmente” interesados en incorporar a su oferta la ingestión y análisis del volumen de datos que generan las grandes empresas que son sus clientes. Y esto desaloja del terreno a otra especie inferior, por mucho que su logo sea un elefante.

Ciertamente, no todos los datos van a ir a la nube y por distintas razones habrá muchas cargas de trabajo que seguirán ejecutándose on-premise. Pero ya es sintomático que casi nadie hable de Hadoop, que llegó a ser sinónimo de plataforma para el análisis masivo de datos.

Permitan una breve recapitulación. Hortonworks salió a bolsa en 2014 y Cloudera tres años después, ambas con discreto optimismo de los inversores. El tercer exponente de la misma corriente, MapR, no se atrevió a tanto: recaudó 250 millones de dólares de venture capital y se endeudó lo necesario para seguir atrayendo clientes de postín, que los tiene. Hasta que, la semana pasada, su CEO John Schroeder, comunicó públicamente que a MapR le queda fuelle para pocas semanas, a menos que aparezca una solución financiera.

Tanto Cloudera, como a su medida MapR, han tratado valientemente de escapar a la identificación con Hadoop que podía penalizarlas, para internarse en unos terrenos que (hoy, ya veremos mañana) suenan muy fashion: microservicios, procesadores en memoria (Spark), contenedores (Kubernetes). Con este perfil esperaban ser apreciados como alternativas viables ante los musculados proveedores cloud.

Ya no basta, al parecer, con los atributos de Hadoop y su sistema de ficheros HDFS. “Las grandes empresas globales son negocios complejos cuyos casos de uso requieren múltiples funciones analíticas, buscan soluciones hibridas y capacidad de mover sus datos de una ubicación a otra óptima para minimizar costes y maximizar eficiencia”, disertaba Reilly en marzo al presentar en sociedad Cloudera Data Platform (CDP). En la práctica, se trata de un híbrido para que las empresas puedan mover ´inteligentemente` sus cargas de un centro de datos a una nube o viceversa.

Automatización y capacidad de escalar son ingredientes de toda oferta que hoy se formule, así que CDP no podría ser menos. Está por ver que llegue a ser un arma suficiente contra los recursos de AWS, Azure y Google Cloud, en un mercado que hasta ahora parecía satisfecho con Hadoop y los servicios asociados que monetizan su naturaleza open source.

Estoy demasiado lejos de ser un experto en la materia, pero amigos a quienes tengo por tales me han dicho que la pérdida de protagonismo de Hadoop obedece a que los tres grandes proveedores de infraestructura como servicio incluyen capacidades similares como parte de su catálogo: AWS (Lambda, Kinesis Data Stream, DynamoDB) o Azure (DataFactory, Databricks y Cosmos DB).

No me atrevo a sacar conclusiones precipitadas, pero tal vez haya en ello una moraleja sobre los efectos potenciales del modelo cloud sobre tantas empresas de software independientes. Hoy más que el año pasado me cuesta creer que Hortonworks valiera realmente 5.200 millones de dólares.

7 de junio, 2019

Amazon antitrust AT&T DOJ Facebook FTC Google IBM

No es corriente que una ´no-noticia` alcance tanta repercusión. Quiero decir que por el momento, la única información cierta es que la Federal Trade Commission (FTC) y el departamento de Justicia (en adelante DOJ) de Estados Unidos se han puesto de acuerdo para no pisarse mutuamente, en caso de investigar infracciones de Amazon y Google a la legislación antitrust.

Según ese acuerdo, ventilado sin entrar en detalles, la FTC se ocupará de investigar a Amazon, mientras el DOJ se reserva esa atribución en relación con Google. Por ahora, eso es todo, lo suficiente para alimentar la idea de que se avecinan sendos procesos que, acorde con la experiencia, deberían durar años y tener a los inversores sobre ascuas.

Igual no pasa nada y esto se queda en aviso para navegantes. O es una reacción política ante el auge que ha tomado la crítica a los excesos de lo que se conoce como Big Tech. De entrada, el reparto de tareas podría explicarse porque en 2013, tras dos años investigando a Google, la FTC desistió de acusarla formalmente. Daría lugar a suspicacias que cinco años después de dejar que se fuera de rositas ahora volviera a la carga (qué papelón si tuviera que plegar velas por segunda vez).

Excepto el episodio de 2011 a 2013, ambas compañías han prosperado a placer, sin que los reguladores de su país encontraran objeciones. Lo que ha cambiado es que el poder de que disfrutan ha crecido tanto que está escrito en la agenda política. Las críticas a Google son conocidas: abuso de posición dominante en la publicidad online y en las búsquedas de Internet. En cuanto a Amazon, distintos grupos ciudadanos la acusan de valerse de su control sobre el comercio electrónico para, además de destruir el tradicional, invadir cada espacio de mercado que le apetezca tragarse.

Hay quienes ven reminiscencias del proceso contra Microsoft en los años 90: al cabo de años de batalla, la compañía se salvó de la escisión exigida por las autoridades, tuvo que tomar medidas y pagó 2.200 millones de dólares de multa En realidad, el peor coste no fue el económico: Microsoft gastó unos años preciosos en los tribunales y no supo reaccionar ante la llegada de un competidor que, mira por dónde, ¡era Google!

El argumento que ahora se esgrime difiere sólo formalmente: se denuncia la actuación de Google como propia de un “supermonopolio” que opera en cada espacio de Internet y goza de una posición dominante en varias áreas con la aspiración de extenderla. Sería una postura consustancial a su modelo de negocio (igual que Amazon no se conforma con ser ´sólo` un gigante del comercio electrónico y de los servicios cloud).

Estados Unidos tiene una larga tradición antitrust (la ley Sherman data de 1890) y no puede decirse que haya conseguido triunfos. Así, por ejemplo, un proceso federal contra IBM, iniciado en 1956, se extinguiría muchos años después por abandono del gobierno (que la compañía aprendiera la lección es otra historia). Otro caso célebre, contra AT&T, liberalizó las telecomunicaciones al escindirla en siete babies regionales, pero con el tiempo volvieron a concentrarse en dos megaoperadores (Verizon y la ´nueva´ AT&T).

El episodio actual tiene otra inspiración, que viene de Europa. Muchos de quienes se burlan del “intervencionismo” europeo, admiten que la UE ha sido eficaz en la aplicación de las reglas de competencia. Google ha sido sancionada en tres expedientes distintos con multas que suman 8.200 millones de euros. A cualquier mortal le parece mucho, hasta que cae en la cuenta: son apenas 22 días de los ingresos que Google obtuvo en el primer trimestre de 2019.

Es altamente posible que sea demasiado tarde para que cualquier medida regulatoria produzca un cambio de comportamiento en estas empresas. Es la opinión de Nicholas Economides, profesor de la New York University: “Google ha llegado a ser demasiado prominente, por lo que ningún correctivo podría restaurar la competencia. Creo que se debe a un fallo estructural de un modelo de regulación que si en Europa actúa con lentitud, en Estados Unidos ni siquiera funciona”.

Queda claro, además, que los adversarios que potencialmente podrían beneficiarse de un debilitamiento de Google no son angelitos: se llaman Facebook y Amazon. Los temores que despierta Amazon tienen otra raíz: que pueda valerse (lo está haciendo, de hecho) de su control sobre el comercio online para extender sus tentáculos a otros negocios, contribuyendo a destruir franjas sensibles de la “vieja” economía.

Comoquiera que sea, la opinión pública está perdiendo la ingenuidad con la que acogió a unas compañías que venían a mejorar el mundo y la vida cotidiana. Una decepción colectiva que la está sufriendo Facebook. Algo tiene de insólito el hecho de que el departamento de Justicia invitara a dar una conferencia a Franklin Foer, autor de un libro cuyo título e ya una tesis: World Without Mind: The Existential Threat of Big Tech. O a Roger McNamee, que ha pasado de mentor de Mark Zuckerberg a duro crítico de Facebook.

Mientras las compañías involucradas – y las que no – lubrican su maquinaria de influencia, los medios académicos intentan centrar la discusión. Según unos, los principios de la ley antitrust han perdido sustancia en nuestra era. El segundo argumento no es tan vulgar: se pregunta qué interés público debería proteger prioritariamente la regulación. Veamos: ¿es mejor para los consumidores la multiplicación de la competencia? ¿o acaso es preferible que bajen los precios gracias a que un ¿presunto? monopolio saca ventaja económica de explotar los datos de aquellos consumidores.

Ya quisiera yo ser capaz de entrar en los matices. La hipótesis más conservadora (pero favorable a las investigadas) sostiene que si el poder gubernamental protege a los competidores más débiles, en realidad está favoreciendo la ineficiencia y así ayuda a elevar los precios. La otra es más elaborada: la gratuidad que ofrecen Google y Facebook – o las rebajas y conveniencia de Amazon – son atractivas sólo si no se considera el coste no monetario para los consumidores, que a cambio renuncia a su intimidad y, en el fondo, sacrifican su identidad.

3 de junio, 2019

cartuchos falsificación HP Imaging Supplies Coalition impresión tinta tóner

“Es lo que hay”. Es un sofisma que escucho a menudo, cada vez más a menudo, cuando se me ocurre comentar negativamente alguna tendencia a mi juicio anómala o malévola. Puede tratarse de la superexplotación de los falsos autónomos, de la ruinosa batalla tarifaria entre las telecos o la afortunadamente menguada piratería de software. Obsérvese que los tres casos que cito (hay más) tienen en común la supuesta ventaja que el precio más bajo supone para los usuarios.

En algunos medios que leo habitualmente, he encontrado agudas denuncias de lo que describen como una preocupante proliferación de productos falsificados que circulan sin cortapisas a través de sitios de comercio electrónico o se anuncian en las redes sociales. No me extraña en absoluto, pero me niego a que la respuesta sea el escapista “es lo que hay”.

Las marcas de imitación son un fenómeno tan corriente que da algo de rubor tener que recordar sus efectos nocivos. Empezando, cómo no, por los económicos: según estudios oficiales pero que no me consta si han sido actualizados, representarían hasta un 9,3% de las ventas directas en España.

Coincidiendo con lo anterior, he reparado en una campaña en defensa legítima de los consumibles de impresión, con cuyos argumentos no puedo menos que identificarme. En mala hora se me ocurrió hacer una simple comprobación en Internet: no sólo he comprobado que ese comercio de cartuchos de tinta y tóner existe sino que si en la búsqueda incluyo adjetivos como “barato”, “compatible” o “recargable”, al poco rato recibo ofertas tentadoras cuya tentación está en el precio y la entrega a domicilio.

No estamos ante una práctica periférica ni ante una picaresca folclórica, sino que tiene todos los visos de ser delictiva. Un informe de la Imaging Supplies Coalition (ISC), integrada por cuatro marcas globales de impresión (Brother, Canon, Epson, HP, Lexmark y Xerox) estima que un 8% de los cartuchos que se venden son en realidad productos falsos en distintas acepciones de la palabra y añade que representan una pérdida directa para la industria de al menos de 3.000 millones de dólares.

La primera y más obvia consecuencia es económica: el mercado negro online viene a ser un sumidero que genera evasión fiscal, que no crea empleo y desde luego no necesita I+D porque de eso se ocupan sus víctimas, las marcas legítimas. La segunda es medioambiental: según otra fuente autorizada, HP, el 97% de los cartuchos de imitación terminan en los vertederos, con el agravante de que de la ausencia de reciclaje se nutre de un tráfico secundario de carcasas que, una vez rellenadas con productos de baja calidad, serán reinsertadas en el mercado. Hay quienes hacen como que no ven, porque el subterfugio facilita precios mucho más bajos que los de las marcas que articulan el mercado e invierten en el cumplimiento de las normativas.

Me consta que HP, porque hace años visité sus instalaciones, tiene a gala un sofisticado sistema de recogida y reciclaje de consumibles [está de moda llamarlo gig economy] con un programa de ciclo cerrado que la compañía llama HP Planet Partners. Una vez recogidos – lo que en sí mismo tiene un coste – sus componentes se reutilizan: en la actualidad – informa la empresa – el 100% de sus cartuchos de tóner y el 80% de los de tinta son reciclables.

La táctica de HP se dirige a disuadir al mismo destinatario que – como yo la semana pasada – recibe una publicidad engañosa. Como consumidor individual, la diferencia puede no ser importante, pero sí lo es para las pymes, más sensibles al coste.

Normalmente, el usuario final no tiene idea de los componentes químicos ni del rendimiento y calidad del proceso de impresión que obtienen con esos consumibles de imitación. En la práctica, en esto consiste el engaño, en que no haya manera de distinguir lo falso de lo auténtico.

No hay que mirar muy lejos para saber por qué tantos usuarios pican el anzuelo. Basta con entender una ecuación económica que caracteriza el negocio de impresión y explica por qué entre los usuarios no decaen los malos hábitos: las impresoras se venden a menos de su coste porque el margen que el fabricante sacrifica en el hardware lo recuperará luego a través de la venta de consumibles.

A partir de esta incómoda realidad, el modelo de negocio de las marcas se ha remodelado, primero con ayuda de la tecnología [etiquetas holográficas, software de detección] y, más recientemente, adoptado una fórmula de servicio – también llamada contractual – que, a juzgar por las cifras está siendo bien acogida pero que no ha acabado con la peste.

29 de mayo, 2019

Apple FTC Huawei Lucy Koh MediaTek Qualcomm Samsung Snapdragon

Poco ha durado la alegría de los accionistas de Qualcomm. Exactamente del 16 de abril al 21 de mayo. Tras el acuerdo con Apple que puso fin a una larga batalla judicial, la cotización de la primera subió 23%. Desde que se conoció la sentencia desfavorable a Qualcomm en el proceso iniciado por la FTC (Federal Trade Commission), su acción ha vuelto a caer un 17%. Hasta ayer.

La jueza Lucy Koh, concida por haber presidido otros juicios célebres sobre patentes, ha sentenciado que Qualcomm es culpable de infringir capítulos clave de la ley antimonopolio. En 233 páginas de argumentación, ha logrado algo que ni los competidores ni los reguladores de medio mundo habían conseguido hasta ahora: promover un cambio radical del modelo de negocio de Qualcomm. Si se aplicara el criterio judicial, la compañía se vería obligada a rebajar sus royalties, a renegociar los contratos firmados y a ceder su propiedad intelectual en condiciones razonables a los competidores. El impacto en su cuenta de resultados es imposible de calcular en este momento, pero sería elevado.

Obviamente, Qualcomm recurrirá en todas las instancias a su alcance, por lo que el desenlace tardará años en llegar. Cabe entonces preguntarse qué habría hecho Apple si la secuencia entre ambos juicios hubiera sido la inversa, como durante un tiempo se creyó que ocurriría. Probablemente, a disgusto, se hubiera allanado a negociar un acuerdo, puesto que no tenía alternativa de suministro de un módem con el que equipar su iPhone 5G, previsto para el año próximo.

En sus conclusiones, la jueza deja escrito que “la demandada ha mantenido durante años una conducta que resulta excepcional en la industria. Se ha negado a vender sus chips a los fabricantes de móviles [cita a Motorola, Samsung, Lenovo y Huawei, además de Apple] que no aceptasen firmar un contrato de licencia sobre la totalidad de su cartera de patentes [con independencia de que usaran o no esa propiedad intelectual]; para reforzar su posición no ha vacilado en cortar o retrasar las entregas de software ni en amenazar con retirar el soporte técnico a sus productos”. En cuanto a sus competidores directos (menciona a Samsung, Broadcom y Mediatek) se ha negado a negociar con ellos licencias sobre su propiedad intelectual.

Según dicta la sentencia, Qualcomm deberá someter a la FTC una propuesta de correctivos a la situación descrita, así como un mecanismo de verificación de cumplimiento durante los próximos siete años. Ahora está en manos de la comisión solicitar la aplicación cautelar de la sentencia o – lo más probable – dejarla provisionalmente sin efecto hasta que se resuelva en apelación.

Ya he descrito en este blog el deterioro de las relaciones entre Qualcomm y Apple, de modo que no insistiré. Pero me parece interesante observar que la jueza reflota una cláusula del llamado Marketing Incentive Agreement (MIA) en virtud de la cual Qualcomm ha reembolsado a Apple una parte de los royalties recibidos a cambio de la exclusividad contratada, estipulando que ese pacto caducaría automáticamente si algún producto de Apple incorporase un chip de banda base (módem) de otro suministrador.

También rescata la jueza Koh un episodio hasta ahora conocido sólo parcialmente: Qualcomm aceptó indemnizar a Samsung para que esta retirase su denuncia por prácticas anticompetitivas. Como secuela de ese trato, los smartphones Galaxy destinados a ciertos mercados integran desde entonces procesadores Snapdragon mientras en los otros mercados llevan los Exynos de Samsung.

El modelo de negocio de Qualcomm Inc, se transparenta en su cuenta de resultados. La mayor parte de sus ingresos procede de la venta de chips (su rama QCT) pero obtiene el grueso de sus beneficios de QCL, titular de la cartera de patentes. La llave maestra se resume en un lema, ´No license, no chips´, que aplica a rajatabla. Por cierto, la cuantía a pagar por las licencias se define por el precio final del producto (con un tope de 400 dólares) y no por el coste de las partes suministradas por Qualcomm.

Esta anomalía siempre se ha argumentado por la necesidad de financiar el esfuerzo de I+D que se necesita para mantener el ritmo de innovación adelantándose a las necesidades de la demanda. Esta tesis es, al parecer, compartida por la administración Trump: el departamento de Defensa ha querido influir desde fuera al declarar que Qualcomm es un “campeón nacional” indispensable en el desarrollo de la tecnología 5G. En cuanto al departamento de Justicia, se personó en el proceso para advertir a la jueza que si diera la razón a la FTC [agencia formalmente independiente] provocaría más perjuicios que beneficios” en la capacidad competitiva de Estados Unidos. El recurso de Qualcomm deja este argumento en manos de un tribunal superior.

Lo que me lleva inevitablemente al contexto actual, marcado por la hostilidad de la administración federal contra Huawei y los efectos de la así llamada guerra comercial con China. Baste recordar que la FTC inició el proceso contra Qualcomm en 2017, durante la transición entre Obama y Trump, con una proporción dentro de la comisión que desde entonces se ha invertido a favor de los republicanos.

Prácticamente dos terceras partes de los ingresos de Qualcomm se originan, directa o indirectamente, en China, lo que significa que la compañía está expuesta a circunstancias políticas que no puede controlar. Al mismo tiempo, desde Washington se le asigna un rol esencial en la defensa de la primacía estadounidense en las comunicaciones 5G.

Es cierto que Huawei tiene una (relativa) autonomía, ya que sus smartphones llevan chips de diseño y producción propios. Pero, en comparación, las demás marcas chinas integran chipsets Snapdragon, aunque por el momento no se han visto afectadas por las medidas arancelarias de Donald Trump.

De ello podría deducirse que Qualcomm ha podido hasta ahora proteger su modelo de negocio gracias a un monopolio “natural” que ni siquiera Intel ha podido romper. Bueno, alternativas hay: Samsung tiene sus Exynos, Huawei sus Kirin así como MediaTek tiene sus Helio. Aun así, la ventaja adquirida por Qualcomm en las tecnologías 5G se antoja decisiva. Tecnológicamente, sin duda, pero sus accionistas acaban de descubrir un factor inesperado, la repentina incertidumbre jurídica.

17 de mayo, 2019

Apple Bob Swan Brian Krzanich Intel Johny Srouji Qualcomm Tim Cook Venkata Renduchintala

Intel ha dado pie a varias noticias en las últimas semanas. Una buena, la nueva familia Xeon para centros de datos. Otra tardía, el anuncio de que en el segundo semestre se normalizará el suministro de procesadores para portátiles que tiene muy disgustados a los fabricantes de PC. Y una tercera, que parece no tener arreglo: la pérdida de Apple como cliente para los módems de la próxima generación de iPhone, consecuencia del acuerdo que reintegra ese negocio a manos de Qualcomm. De la tercera noticia voy a ocuparme en este newsletter. Me facilita mucho la tarea un artículo de Aaron Tilley (en The Information) que reconstruye las entretelas de lo que llama el divorcio entre Apple e Intel.

Un par de horas después de conocerse el acuerdo entre Apple y Qualcomm, que deja fuera de juego a Intel en el desarrollo de un módem 5G, Bob Swan anunció que esta última abandona sus esfuerzos por falta de perspectivas de rentabilidad. Tilley rastrea el desencuentro hasta 2010, cuando Intel adquirió activos de Infineon por 1.400 millones; buscaba resarcirse del error de no haber aceptado participar del proyecto de iPhone al que había sido invitada por Steve Jobs. Como es sabido, en 2011 Apple se echó en brazos de Qualcomm como único suministrador durante cinco años. Intel tardó en desmontar sus equipos, que en cierto momento habían sumado 7.000 personas dispersas en 32 sitios alrededor del mundo.

En 2015, Brian Krzanich, CEO de Intel hasta el año pasado, había tomado la iniciativa de fichar a Venkata (Murthy) Renduchintala, que dirigía la ingeniería de Qualcomm, pero este fue resistido por veteranos que desde entonces pasarían a estar a sus órdenes. De pronto, el viento pareció cambiar en 2016: Apple, que ya barruntaba un conflicto con Qualcomm, negoció con Intel para que le suministrara un módem – 8060 según la nomenclatura – desarrollado en conjunto, para equipar una parte de los iPhone 7, si bien Qualcomm siguió como proveedor del resto hasta que se rompieron las relaciones.

Curiosamente, los vaivenes de Intel le impidieron aprovechar esta segunda (o tercera) oportunidad: el prototipo del siguiente módem 5G (8160) no convenció a Johny Srouji, senior VP de tecnología de hardware de Apple, quien recomendó a Tim Cook hacer las paces con Qualcomm [un vídeo en el que elogiaba la tecnología de esta fue mostrado durante el juicio].

No fue plato de gusto para Cook desdecirse de la demanda y aprobar el pago de 4.500 millones de dólares a su adversario (y nuevamente proveedor) en concepto de royalties atrasados. El premio será, algún día, completar el desarrollo de su propio módem, una tarea que según fuentes de Tilley podría llevarle hasta 2025.

El deterioro de la confianza entre Apple e Intel amenaza la continuidad del contrato de suministro de procesadores para la familia Mac. El mes pasado, Cook expresó públicamente su decepción, lo que ha llevado a suponer que tiene planes de autoabastecimiento, quizás el año próximo.

Entretanto, algunos quisquillosos andan quejándose de que el consejo de Intel tirara por la calle del medio y escogiera como nuevo CEO a Bob Swan, antes CFO y el primero en alcanzar esa posición sin haber estudiado ingeniería. Bueno, qué quieren que les diga, a juzgar por los vídeos que he visto, puede que Swan no tenga la soltura escénica de su predecesor, pero la verdad es que los problemas que afligen a Intel no los ha creado ningún financiero ni ha sabido resolverlos ningún ingeniero.

9 de mayo, 2019

Deutsche Telekom Liberty Global Markus Haas Mike Fries Telefónica Tim Hoettges Vodafone

Parece estar próxima la autorización de la compra de activos de Liberty Global por Vodafone, cuyo eje de gravedad es el impacto que pudiera tener sobre el mercado alemán. A despejar la incertidumbre ayudará el acuerdo alcanzado entre Vodafone y Telefonica Deutschland, por el cual la segunda podrá dar servicios de banda ancha basados en la red combinada de la filial de Vodafone y Unitymedia – marca de Liberty Global en el país – que cubrirá 23,7 millones de hogares. El acuerdo satisface una de las objeciones planteadas por la Comisión Europea, que debería tomar una decisión antes de finales de junio.

Es pronto para echar las campanas al vuelo, pero la aprobación de esta transacción podría marcar una inflexión en la hostilidad de Bruselas hacia todo aquello que se interprete como luz verde a la consolidación del sector de las telecomunicaciones en Europa, por debajo de la cifra “áurea” de cuatro operadores por país. En este caso, el eje de gravedad es el impacto que pudiera tener sobre el mercado alemán, en otros podría esgrimirse otro argumento.

No obstante, la circunstancia no es del todo homologable al resto de la UE por dos peculiaridades del mercado alemán: la segmentación geográfica de la competencia y el fuerte peso de la infraestructura de cable que, en la práctica, ha retrasado los despliegues de fibra.

Inicialmente, Vodafone y Liberty Global sostenían que al no solaparse sus zonas de operación, no cabía argumentar un recorte de la competencia, pero no fue suficiente para acelerar las cosas. Gran parte del ejercicio de convicción ha consistido en prometer que no se propone desplegar redes en el territorio de otro operador: “incluso juntas, las dos compañías serán la mitad de tamaño del operador incumbente; ya es hora de que el mercado adopte una dinámica de estímulo a la inversión”, puntualizaba el CEO de Liberty Global, Mike Fries, durante el reciente MWC.

La razón primaria de comprar esos activos es transparente: una estrategia ´convergente´ de empaquetamiento de servicios de banda ancha para desafiar el dominio de Deutsche Telekom y dejar en un plano inferior a Telefonica Deutschland. Una vez completada la compra, Vodafone se convertiría en el mayor proveedor de banda ancha fija y cable de Europa.

Tim Hoettges, CEO de Deutsche Telekom [el Estado retiene un 15% de participación] sobreactuó de entrada su oposición a la adquisición, llegando a sostener que conduciría a un monopolio de la TV por cable en Alemania. Posteriormente, rebajaría su crítica poniendo como única condición que ningún operador pueda desplegar nuevas redes en territorio asignado a un competidor, exigencia que había sido aceptada de antemano.

Más comedida fue la actitud de Telefonica. Su filial germana controla una cuarta parte del mercado de telefonía móvil, detrás de Deutsche Telekom pero por delante de Vodafone; sin embargo, está muy rezagada en la banda ancha fija, con una cuota del 6%. El CEO de Telefonica Deutschland, Markus Haas, declara que el acuerdo con Vodafone – condicionado a que la otra parte consiga la autorización para cerrar la compra – le permitiría “conectar millones de hogares adicionales con Internet de alta velocidad […] y disponer de una extensa infraestructura para ofrecer productos de banda ancha, incluyendo nuestro servicio O2 TV”.

Cuando se asiente la tormenta de arena, el paisaje del mercado alemán empezará a cambiar. Vodafone heredará los acuerdos por los que Unitymedia prestaba servicio alquilando la red de Deutsche Telekom, mientras que Telefonica Deutschland tendrá asegurada la posibilidad de ganar escala gracias a que Vodafone queda obligada a darle acceso mayorista a su red. Otras objeciones, planteadas por los operadores de TV por cable, podrán solventarse con acuerdos fácilmente negociables.

Una de las preguntas recurrentes es en qué cambia la posición financiera del grupo Vodafone. La nueva CFO, Margherita della Valle, anticipa que la integración de los activos de Liberty Global [Alemania, República Checa, Hungría y Rumania] generará unas sinergias de 535 millones de euros anuales. Los ahorros de costes serán “similares” a los que el grupo obtuvo con las integraciones de Kabel Deutschland (2013) y la española Ono (2014). Las claves – dijo – serán la compartición de redes y sistemas, la optimización de compras y la supresión de funciones superpuestas, sin contar con unos 1.500 millones de euros en servicios cruzados a las dos bases de clientes. Cuando la transacción se consume, Vodafone espera que los servicios fijos y de TV pasen de representar el 29% al 35% de sus ingresos.

24 de abril, 2019

Dell Dheeraj Pandey HCI HPE Nutanix Sanjay Poonen VMware

Para comprender por qué Hewlett Packard Enterprise (HPE) y Nutanix han firmado un acuerdo a priori impensable, habría que reconstruir la secuencia previa. A eso voy: el 1 de marzo, tras publicar los resultados – poco brillantes pero no malos – de su segundo trimestre fiscal, Nutanix sufrió un castigo bursátil que hundió su cotización en un tercio. Más que las cuentas en sí, los inversores sobreactuaban la reacción a la previsión de un tercer trimestre (el actual) del que la compañía espera crecimiento plano.

Desde entonces, la acción ha recuperado la mitad de lo perdido. Lo peor es que, a punto de cumplir diez años de existencia (nació en 2009) y dos años y medio desde su salida a bolsa en 2016, Nutanix sigue sin conocer los beneficios.

Vale, pero el fundador y CEO de la compañía, Dheeraj Pandey, salió del paso explicando el batacazo como un efecto a corto plazo de algunos errores de marketing. Se calló algo: el modelo de negocio de Nutanix atraviesa una transición: ha abandonado la venta de hardware para vivir sólo de su software, algo que Wall Street suele premiar pero que, en este caso, llevaba a la convicción de que Nutanix no tiene el compañero de viaje más adecuado para la nueva etapa. Me refiero a Dell, claro.

Pandey retomó pronto la iniciativa y estuvo convincente ante los analistas: Nutanix, dijo, tiene potencial para duplicar su facturación alcanzando los 3.000 millones de dólares en 2021. Afirmó, y no era la primera vez, que en las infraestructuras hiperconvergentes (HCI) se abriría pronto una nueva oportunidad.

Ahora sabemos de qué oportunidad hablaba. Se estaba cociendo un acuerdo estratégico con HPE, anunciado hace un par de semanas. Su objetivo no es otro que arrebatar a la pareja Dell-VMware el liderazgo del mercado de HCI y de paso del de servidores.

Según los últimos datos de IDC, el mercado de sistemas HCI tiene un líder claro, Dell, con un 28,6%, al que persigue Nutanix con un 14,8% (ha bajado cuatro puntos, y eso duele); HPE no está conforme con ser tercera (5,4%). En el ranking de software, VMware lleva la voz cantante (38,1%) con Nutanix a dos puntos, lo que significa que se reparten 7 de cada 10 dólares de facturación. En cuanto al mercado de servidores, en unidades lo encabeza Dell (19,4%) con HPE en segundo lugar (15,8%). Es fácil ver contra quien va dirigido el acuerdo entre los segundos de cada mercado.

Asumo el riesgo de que pueda parecer ociosa la explicación de qué es un sistema hiperconvergente. Combina las funciones de computación, almacenamiento y virtualización, aliviando la tarea de gestionar sistemas separados; su despliegue es más rápido y la inversión de capital más baja. Así ha ido adquiriendo su fisonomía un mercado expansivo que, al finalizar 2018, crecía nada menos que un 57%.

A lo que iba, se ha movido el tablero. Desde 2014, Nutanix ha mantenido una provechosa alianza con Dell que le hacía mostrarse desdeñosa hacia HP (la actual HPE). Pero esa alianza empezó a tambalear cuando Dell adquirió EMC y con esta el 81% de VMware, cuya dote incluía el desarrollo de la solución hiperconvergente vxRail.

Mientras esto ocurría, Nutanix estaba saliendo a bolsa y los analistas vieron en su alianza con Dell un baluarte que elevaba el valor de la compañía. Aun así, tarde o temprano la suma de Dell y VMware acabaría fastidiando a Nutanix.

Lógicamente, sus reproches no se han centrado en Dell sino en VMware. , El CEO de Nutanix y el COO de VMware, Sanjay Poonen, han intercambiado durísimas palabras en sus respectivos blogs. Poonen sosteniendo que el software de Nutanix es una copia; Dheraj Pandey aludiendo a lo que llama “vTax” [sobreprecio que, según él, pagan los usuarios de VMware por usar su hipervisor cuando podrían usar el de Nutanix gratuitamente].

Sin llegar a esos extremos, la antipatía entre Nutanix y HPE ha sido manifiesta, precisamente porque Dell era el obstáculo. Y con más motivo desde que HPE decidió adquirir Simplivity en 2017 para no quedar descolgada del ascendente mercado de HCI.

Creo recordar que la última vez que estuve de visita en HPE el cuadro era este: 1) HPE/Simplivity no tenía un hipervisor nativo propio, a diferencia de Nutanix; 2) el software de Simplivity corría en servidores específicos de HPE dentro de una estrategia llamada de “infraestructura componible”, pero no en los de otros fabricantes ni en los ProLiant y Apollo de marca propia; 3) Nutanix procuraba sacar partido de lo anterior cortejando a los usuarios de esas dos familias de servidores.

La fórmula que ambas compañías han encontrado para unir fuerzas es la siguiente. Por una parte, una solución integrada llave en mano, que implica precargar Enterprise Cloud OS, el sistema de Nutanix que incluye AHV, en servidores ProLiant y Apollo. Por otra, el software de Nutanix estará disponible en la solución hibrida HP GreenLake de pago por uso.

Oficialmente, el acuerdo es presentado como una respuesta a la demanda del partners y clientes: “ambas compañías reconocen que existe mercado para que el software de Nutanix corra en servidores de HPE y ofrezca las ventajas del modelo as-a-service”. La próxima conferencia de Nutanix en mayo será la puesta de largo del acuerdo.

22 de abril, 2019

5G Apple FTC Huawei iPhone Paul Jacobs Qualcomm Samsung Steve Jobs Steve Mollenkopf Tim Cook

El acuerdo in extremis que ha puesto fin a la batalla judicial entre Apple y Qualcomm da pie a conjeturar sus connotaciones políticas. Cualquiera que fuera el desenlace del juicio en San Diego – y de los recursos que a buen seguro le seguirían – habría sido desastroso para una potencia que pretende asegurarse la supremacía sobre las tecnologías de las redes 5G. En el tribunal del circuito de San Diego, a la sazón presidido por el juez Gonzalo Curiel, se confrontaban las dos únicas empresas estadounidenses capaces de plantar cara a la competencia asiática en ese terreno.

De haber ganado Apple, habría sido dañado gravemente el modelo de negocio de Qualcomm, perdiendo valor una buena parte de su cartera de patentes, susceptibles de ser cuestionadas por terceros. Una posible victoria de Qualcomm implicaba que Apple no tendría capacidad para presentar un iPhone 5G a tiempo para el despegue del mercado a partir del año próximo, sin contar con que esa carencia debilitaría su pregonada estrategia de servicios, cuyos primeros destinatarios son los usuarios del iPhone.

El anuncio del acuerdo es sumamente escueto, pero al menos deja claro que Apple será licenciatario directo de Qualcomm durante seis años, más otros dos años opcionales, a contar desde el 1 de abril; en consecuencia, le pagará royalties – de cuya cuantía nada se informa – que tal vez sea (o no) equivalente a los 7,50 dólares por cada iPhone vendido que Apple pagó entre 2011 y 2017 y que desde entonces ha rehusado abonar, es la raíz de este conflicto. Adicionalmente, Apple hará un desembolso único en favor de Qualcomm, aparentemente compensatorio por pagos devengados y no desembolsados.

Se reanudará de inmediato y durante varios años [atención: no se dice cuántos] el suministro de chipsets de Qualcomm. Asímismo, decae todo litigio pendiente entre las dos compañías. Los contratistas que han secundado a Apple en su cruzada (Foxconn, Pegatron, Wistron y Compal) se librar de problemas judiciales.

Con esto, de la noche a la mañana se ha producido un reordenamiento del mercado de smartphones. ¿A qué se debe la prisa por cerrar la trifulca? Una hipótesis plausible apunta que Apple optó por tirar la toalla tras ser informada por Intel de la imposibilidad de cumplir el compromiso de desarrollar un modem 5G – alternativo al ya existente de Qualcomm – que debería equipar la siguiente generación de iPhone que verá la luz en 2020.

Por tanto, ¿en qué situación queda cada uno de los protagonistas de este episodio? Empezaré por el vencedor. Qualcomm ve desvanecerse las amenazas a su modelo de negocio, consistente en desarrollar tecnologías (en este caso 5G) y en vender chips basados en ellas, además de cobrar licencias por su ingente cartera de patentes. El acuerdo cerrado con Apple es un alivio para un equipo directivo que venía de sufrir dos golpes: la oferta de compra presentada por Broadcom y bloqueada con ayuda de la Casa Blanca, y la fallida adquisición de NXP, especialista en chips para la industria de automoción.

En este momento, a Qualcomm sólo puede preocuparle lo que pase con otro juicio, una acusación de prácticas anticompetitivas iniciado por la FTC (Federal Trade Commission) e inspirado en argumentos similares a los esgrimidos por Apple. Este procedimiento está a cargo de la juez Lucy Koh – célebre por haber llevado el dilatado caso de Apple vs. Samsung, cerrado en tablas – que debería estar ya sentenciado. Ahora bien, sería un auténtico seísmo que, después de lo pactado, la juez Koh fallase contra Qualcomm.

En cualquier caso, el acuerdo habrá sido duro de tragar para Tim Cook, quien en 2011 cuestionó internamente las negociaciones de Steve Jobs con Paul Jacobs (hijo del fundador de Qualcomm) que dieron lugar al compromiso de pagar royalties sobre el valor total de un iPhone y no sólo por el de los componentes protegidos por patentes. A la muerte de Jobs, Cook tuvo que gestionar el hecho consumado; dicen que nunca se ha llevado bien con el sucesor de Jacobs, Steve Mollenkopf. En fin, que tiene motivos para consolarse: se despeja la capacidad de Apple para replicar a Samsung, que ya tiene un smartphone 5G en dos mercados (Corea y Estados Unidos) y a Huawei, que tiene el suyo a punto.

El paso atrás de Apple es sólo relativo. No está obligada a cancelar sus planes para desarrollar su propia capacidad de producir un modem, tal como ha hecho con el procesador de aplicaciones. Provisionalmente, Cook se había puesto en manos de Intel, pero en su página web hay constancia de que busca ingenieros especializados en esa tecnología. Y de que los busca, por algo será, en la vecindad de la sede de Qualcomm en San Diego.

Por si un lector se pregunta por qué hay tanto jaleo por un módem, la respuesta es que se trata del componente clave que conecta un dispositivo móvil con la red. Una gran complejidad en un mundo en el que cada operador diseña la red según su conveniencia, usa equipos dispares y dispone de frecuencias diferentes. Integrar un módem con tal variedad de tecnología, requiere más capas de ingeniería que casi cualquier otro semiconductor. Por otra parte, cada smartphone destinado al mercado global tiene que pasar por la certificación de cada red y por riugurosas pruebas de compatibilidad.

Si una empresa como Intel se ha echado atrás ante la magnitud de la tarea, algo querrá decir. Vamos, pues, con el perdedor de esta historia, Intel. Al poco rato de darse a publicidad el acuerdo entre Apple y Qualcomm, anunció su decisión de abandonar el desarrollo de chips para smartphones por – textualmente – no apreciar su rentabilidad futura. En realidad quería decir Intel que, si su único cliente se marcha, no tendría sentido insistir. O quizás fue la propia Intel la que, desconfiando de las intenciones de Apple, se echó a un lado y esto precipitó el acuerdo. Tómese como una hipótesis.

En todo caso, no ha sido el primer tropezón de Intel. En 1999 pagó 1.700 millones de dólares por la empresa DSP para entrar en el mercado de los móviles de entonces, pero se arrepintió y la revendió en 2003. El difunto Paul Otellini se autocriticó tardíamente por no haber acogido en 2007 la invitación de Apple a participar en el primer iPhone. Otra ocasión fallida fue la adquisición (2011) de activos de la germana Infineon por 1.400 millones.

En esta oportunidad, al menos, la frustración no hará que Intel abandone sus inversiones para estar presente en las infraestructuras de redes 5G, tema central de su presencia en el pasado Mobile World Congress. Pero de esto me ocuparé otro día, porque me he pasado de las 1.000 palabras.

3 de abril, 2019

Apple Banca David Solomon fintech Goldman Sachs Mastercard Samsung Tim Cook

En palabras de Tim Cook, Apple Card es “la mayor innovación [de los sistemas de pago] en 50 años”. Le secundó David Solomon, CEO de Goldman Sachs, para quien “cambia por completo la experiencia [de los usuarios] de tarjetas de crédito”. Si esto es así, ¿por qué razón Apple decidió ´empaquetar` el anuncio en el mismo acto de presentación de nuevos servicios: Apple TV+, Apple Arcade y Apple News? Mi hipótesis es que se quiere transmitir la idea de “una tarjeta de crédito diseñada por Apple”, con guiños al consumidor que ratifican una estrategia de ”jardín vallado” que la compañía ha cultivado al menos desde el lanzamiento del primer iPhone.

No es un producto (como sería un dispositivo o un accesorio) ni estrictamente es un servicio por suscripción (como iTunes o Apple TV+). La innovación que trae Apple Card es su aportación al modelo de negocio: no se trata de que el iPhone deje de ser el centro de su sistema solar, sino de que el astro irradie un flujo añadido de dinero generado por los servicios y contenidos propios, además de explotar otras oportunidades de gasto lúdico, financiadas con deuda.

Para que así sea, se requiere disponer de un instrumento financiero ex profeso, un medio de pago bajo su estricto control. La tarjeta está embebida en el wallet virtual de Apple, cuyo exponente hasta ahora ha sido la aplicación Apple Pay. Por lo visto, ha alcanzado un volumen y una fidelidad entre los usuarios de la marca que permite ir más lejos.

La semana pasada encontré un titular según el cual Apple se transforma en banco. Esta simplificación es falsa. En primer lugar, para actuar como banco, necesitaría una “ficha” en cada jurisdicción y ajustarse a las normativas, dos requisitos que no están entre las intenciones de la compañía. Y, si damos por sentado que un banco asume riesgos, la verdad es que con el lanzamiento de su tarjeta Apple no corre ningún riesgo financiero: los asume enteramente Goldman Sachs. Un socio que aúna dos peculiaridades a tener en cuenta: a) no es emisor de tarjetas bajo su marca y b) más que minoritario, su negocio minorista es periférico. Eso sí, Goldman Sachs remunerará a Apple por cada usuario. Hay un tercer actor necesario: Mastercard contribuye con su tecnología de `tokenización` y de paso se apunta puntos en su rivalidad con Visa.

Esta combinación tripartita hace posible afirmar, faltando sólo un poquito a la verdad, que Apple no traiciona a los bancos que durante cinco años han acompañado su sistema Apple Pay, del que la nueva tarjeta vendría a ser un complemento físico. Esos bancos podrán quejarse o no, pero tendrían motivo: en lugar de un ´ecosistema abierto` – como el que preconiza Samsung Pay, por ejemplo – en el que el usuario decide con qué plataforma bancaria quiere operar, Apple les pone otra cortapisa, acorde con su naturaleza.

Durante años, consultores, columnistas (y banqueros) han alertado sobre un fantasma bautizado como fintech. Al calor de esa prédica han proliferado en todo el mundo iniciativas oportunistas que han picoteado en segmentos menores – pero rentables – del negocio bancario. No es el caso de Apple, pero resulta innegable que los bancos se enfrentan a un escenario nuevo. No tanto como para encarnar una amenaza sistémica.

Como es habitual, la presentación del lunes fue vistosa pero escasa en detalles. Se sabe que Apple Card estará disponible en Estados Unidos este verano [por supuesto, ninguna indicación sobre su internacionalización o la entrada de otros bancos emisores]. Abundaron las menciones a las garantías de privacidad con las que Apple – que al no vivir de la publicidad no necesita recoger más datos personales de los necesarios ni distribuirlos a terceros – marca diferencias con Alphabet y Facebook (eventualmente también con Amazon).

La privacidad – y la seguridad que conlleva – podrían no ser suficientes para que los consumidores usuarios de Apple se apunten masivamente. Por esto, la novedad más atractiva de Apple Card es Daily Cash: para preservar la fidelidad a Apple Pay, el usuario tendrá una bonificación del 2% de cada compra hecha con la app; si sólo usara la tarjeta física, sería del 1% y si se tratara de una compra en la App Store o de un servicio de la marca, del 3%. Con la particularidad de que el reembolso se haría efectivo inmediatamente después de cerrada la transacción, y el consumidor tendrá en todo momento en pantalla la información de sus movimientos y saldo disponible.

Otro argumento a favor es la ausencia de cuota anual y comisiones por exceso de gasto. Ante tanta facilidad, es razonable preguntarse por qué Apple (y Goldman Sachs) descartan la emisión de una tarjeta de débito. La respuesta, elusiva, está en el tipo de interés aplicable. Según Cook, “están entre los más bajos del mercado”. No me atrevería a contradecirlo, pero en una nota al pie de la página informática se especifica que los intereses serán variables, en un rango que – calculado en marzo de 2019 – oscilaría entre el 13,24% y el 24,24% anual, dependiendo de la calificación del deudor. Lo que se llama un chollo.

Norberto

20 de febrero, 2019

Amazon Facebook Google Jeff Bezos Nueva York Seattle

Cuando Jeff Bezos anunció en noviembre que la segunda sede (HQ2) de Amazon se repartiría entre Arlington, al lado de Washington DC, y Queens, en Nueva York, no supo ´leer` los resultados de las elecciones legislativas de unos días antes. También erraron Andrew Cuomo y Bill de Blasio, gobernador y alcalde, respectivamente, de Nueva York, que pujaron fuerte para atraer a la compañía a su territorio.

El insólito concurso de catorce meses al que concurrieron nada menos que 238 ciudades en Estados Unidos y Canadá, a ver cual era más generosa con tal de congraciarse con el magnate del comercio online, ha desembocado en fiasco sobre el que se debatirá durante bastante tiempo. De momento, en vista de una oposición que no esperaba, ha renunciado al proyecto de 2.500 millones en Nueva York.

El episodio presenta matices que ilustran el cuestionamiento social de los arrogantes amos de Internet, presuntos hacedores de ´un mundo mejor`. En este juicio sumario caben tanto las críticas a Facebook por su manejo irregular de los datos personales, como las manifestaciones callejeras de empleados de Google disconformes con los tratos que la compañía tiene con el Pentágono. Y, por lo que se ve, también las sospechas que despierta Amazon.

Empecemos por la política. Cuomo y de Blasio – dos demócratas que se llevan fatal – han coincidido en algo, en ofrecer 3.000 millones de dólares en ventajas fiscales a Amazon para asegurarse la creación de 25.000 puestos de trabajo. Con ese dinero podían haber empezado por rehabilitar la cochambrosa área de Long Island City, donde debía instalarse la HQ2. Las encuestas decían que el 56% de los neoyorquinos aprobaba la llegada de Amazon, pero las figuras emergentes del partido, de otra generación y situadas a la izquierda, han hecho oposición a que la ciudad regale dinero a una empresa cuyo valor en bolsa está en torno al billón de dólares.

No se trata sólo de la desgravación fiscal: la instalación de un megacampus en Queens traería especulación inmobiliaria [ha durado dos meses antes de pinchar], encarecimiento de los alquileres, saturación de las escuelas y agravamiento del caos de tráfico no lejos del aeropuerto.

Un documento presentado por Cuomo en su campaña de reelección– que, dicho sea de paso, arrasó – sostenía que la subvención retornaría multiplicada por nueve en 25 años gracias a los tributos a pagar por la compañía y sus empleados. La afirmación fue rápidamente desacreditada al trascender un estudio según el cual Amazon no pagará un solo dólar por sus beneficios de 2018, que fueron de 11.200 millones de dólares. Por el contrario, tendrá derecho a devolución de 128 millones con cargo a pérdidas de ejercicios anteriores.

Amazon ha vivido dos décadas despreocupándose de los beneficios, con el argumento – aceptado de buen grado por los inversores – de que debía reinvertirlos en una diversificación que agrandaba a cada paso su perímetro. Por fin, en 2017 empezó a presentar beneficios y los analistas de Wall Street estiman que dentro de cinco años ganará entre 40.000 y 60.000 millones anuales.

Puede que la gota que colmara el vaso de los activistas fuera el estúpido anticipo de que el grupo de edificios, donde pensaba instalarse, contará con un helipuerto para que sus ejecutivos eviten los embotellamientos viales. Eso y proclamar en voz alta que es una empresa no igualitaria ha sido todo uno. Y el horno no está para bollos.

Las críticas llovieron sobre Bezos, desde el izquierdista Bernie Sanders hasta el inclasificable Donald Trump se despacharon a gusto en Twitter. En una inusual coincidencia, el New York Times y el Wall Street Journal se expresaron en contra de la oportunidad de subvencionar a la segunda empresa más valiosa del mundo. Y hasta el Washington Post, propiedad de Bezos, entendió que debía demostrar su independencia editorial.

Para Nueva York, el fracaso de la iniciativa no es una gran pérdida, dadas las circunstancias económicas: la ciudad ha vivido el año pasado la creación de 100.000 puestos de trabajo. En cuanto a la otra parte, el impacto de echarse atrás tampoco cambia gran cosa para Amazon. Primero: sólo tendrá que desplazar a otro sitio la inversión calculada y quizás ahorrarse una parte. Segundo: mantendrá sus 5.000 empleos actuales en Nueva York e instalará un nuevo centro de distribución en terrenos que ha comprado en Queens.

El factor que motiva su repliegue parece ser otro. El alcalde de Blasio había dicho públicamente que confiaba en que la empresa cambiaría su política laboral y su hostilidad a los sindicatos. De eso nada, por ahí no pasa Amazon. Esta consideró una encerrona la invitación a sindicalistas a una reunión con el gobernador Cuomo. En este sentido, puede decirse que la actitud de Amazon pretende ser ejemplarizante a su manera.

Cuenta el New York Times que esta ha sido la línea roja que Bezos se negó a cruzar. De palabra, Amazon dice respetar los derechos de sus trabajadores, pero es conocida en todo el mundo como un caso extremo de explotación intensiva de la mano de obra que emplea [no lo digo yo, lo dicen los trabajadores de sus centros en España]. Aunque legalmente no puede oponerse a la afiliación sindical, nadie que haya tratado de dar ese paso ha conservado su empleo.

El plan de abrir una segunda sede se origina en los problemas que el crecimiento de la primera ha creado en Seattle, ciudad donde la fundó Bezos tras abandonar – qué ironía – Nueva York, donde trabajaba como broker. La escala alcanzada en Seattle hace que Amazon cargue con la culpa de todos los problemas de la ciudad, desde la crisis de vivienda a los monumentales atascos. Su negativa a apoyar una tasa propuesta para aliviar a los homeless, agravó las suspicacias. De ahí la necesidad de buscar un desdoblamiento operativo.

Esta iniciativa, y su malhadado desenlace, desafían la tesis que los economistas llaman “efecto aglomeración”; se supone que la eficiencia de las empresas mejora mediante la creación de clusters de empleo. Al final, depende del tipo de empleo que se quiera crear. Por la naturaleza de su negocio, Amazon puede permitirse una descentralización radical. Reducir la ambición de su HQ2 no cambia lo esencial: en Estados Unidos, seguirá teniendo 17 hubs regionales y los empleos que necesite crear los dispersará. Lo que no hará será convocar otra competición entre ciudades.

Aunque sea una historia americana, el fiasco revela otros aspectos que merecen reflexión entre nosotros, ahora que se abre la temporada electoral. Por un lado, está el sinsentido del cortejo que bailan los gobiernos regionales siempre con dos pretextos: empleo e innovación – sí, estoy pensando en nuestras CCAA y en el descaro de algunas startups de cartón piedra – con la promesa de incentivos fiscales de dudosa utilidad final. Segundo: la imagen pública de las empresas tecnológicas se deteriora a ojos vista, debido a la percepción de su ostentosa omnipotencia. Y tercero: existe un riesgo de distorsión ciudadana causada por las expectativas exageradas y su frustración posterior. Tiempo habrá de volver sobre el asunto.

14 de febrero, 2019

Altice Analysys Mason AT&T espectro infraestructuras Macquarie Telefónica

Durante diciembre y enero he recibido decenas de predicciones sobre los más diversos aspectos del mercado de las TI y del comportamiento de los usuarios. Ocurre cada año: suelen ser contenidos prefabricados con la única finalidad de barrer para casa de la empresa remitente. Nadie se ocupará dentro de un año de revisar en qué han acertado y en qué han fallado (condición elemental para que algo pueda llamarse predicción]. Las más serias suelen proceder de consultoras.

No quiero ser injusto: el ejercicio predictivo, cuando se distancia del marketing, arroja conclusiones interesantes. Como las que siguen, extraídas de las 10 predicciones de Analysys Mason sobre la actividad de M&A en el sector de las telecomunicaciones. ¿Por qué me han parecido interesantes? Pues porque reflejan el estado de las relaciones nada binarias entre los operadores y los mercados de capitales.

Este año, en el que no se prevén grandes fusiones como las de 2018, la consultora británica presenta otras conjeturas. Pero no se descarta que haya episodios de menor envergadura: “[pensamos que] la actividad M&A de los operadores se centrará en pequeñas adquisiciones para expandir capacidad o mejorar su presencia en el mercado corporativo, con especial foco en los negocios cloud y sobre todo en IoT”-

Los múltiplos de valoración de las infraestructuras [torres, redes de fibra y centros de datos] entendidas como activos apetecibles para la inversión financiera, siguen aumentando. Se combinan dos circunstancias: la necesidad de los fondos especializados de colocar los capitales que han recaudado en espera de destino y, por otro, la escasez de infraestructuras en venta. Esto podría influir en que se haga más frecuente la disociación entre esas infraestructuras y el negocio que soportan.

La segregación y/o desinversión en torres por parte de los operadores es una práctica corriente [Telxius, el ejemplo más cercano] y el encaje de Cellnex con los nuevos dueños de Abertis revela sus rasgos específicos. Pero no es habitual – no todavía – que un jugador financiero adquiera un operador para trocearlo. Analysys Mason menciona la compra del danés TDC por el fondo australiano Macquarie, al que atribuye la intención de segregar sus torres en Dinamarca y Noruega, sin que las cosas estén claras más allá.

Otro caso del mismo género sería el grupo Altice, que intenta desesperadamente vender la red de cable de Portugal Telecom y la de fibra de SFR en Francia, reculando así de su alocada expansión de años atrás. En Estados Unidos, AT&T y Verizon han demostrado que es viable vender sus centros de datos, una conclusión a la que también ha llegado Telefónica y en eso está.

Estas transacciones siempre ayudan a reducir la deuda y son bien acogidas por aquellos a quienes se acude para financiar nuevas inversiones, pero los autores del documento aseguran que los mercados financieros “están presionando” a los ´incumbentes` europeos de telefonía fija para que separen sus negocios minoristas de la operación de infraestructuras, como paso previo a vender participaciones en la red de acceso. Yo, desde una lógica no financiera, me permito objetar que estas maniobras de alivio financiero acabarían a medio plazo devaluando a los operadores y poniéndolos al alcance del tiburón de turno.

Los autores del informe no se meten en ese jardín. Consignan que “los inversores tendrán interés creciente en la combinación de diferentes infraestructuras en un mismo paquete, modelo de negocio que ahora mismo no existe”. La mayoría de los proveedores de servicios de infraestructura – advierten – generan lo más significativo de sus ingresos gracias a una sola clase de activo, pero creen que la convergencia futura de torres, fibra y centros de datos podría desarrollar sinergias y economías de escala. En esta hipótesis, se presiente que los fondos – transparentes inspiradores – se reservarían el papel de agregadores.

Por otro lado, se nos dice que las firmas de private equity le han echado el ojo al mercado de cloud en su variante B2B, muy fragmentado entre pequeños proveedores y, por tanto, de potencial consolidación.

Dejo para el final un apunte sobre 5G. El documento predica que la fibra inalámbrica (FWA) será una gran oportunidad para las telecos si saben encontrar un modelo de negocio capaz de atraer financiación externa. Como en algún momento tendrán limitaciones de espectro, se sugiere que podrían llegar a acuerdos con adjudicatarios de menor talla [cita expresamente a MasMóvil] que no tienen mayor interés en explotarlo directamente. Estos serán, supongo, temas de discusión en el MWC fuera de los focos.

5 de febrero, 2019

Apple Huawei IDC Oppo Samsung Smartphones Vivo Xiaomi

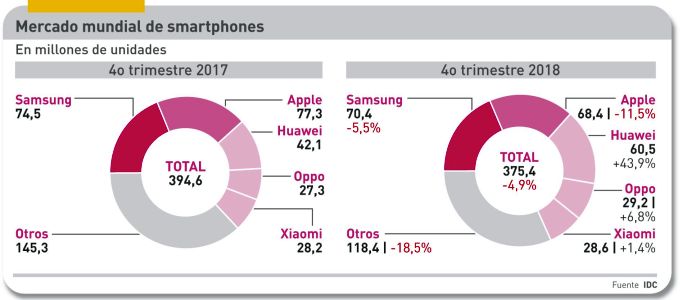

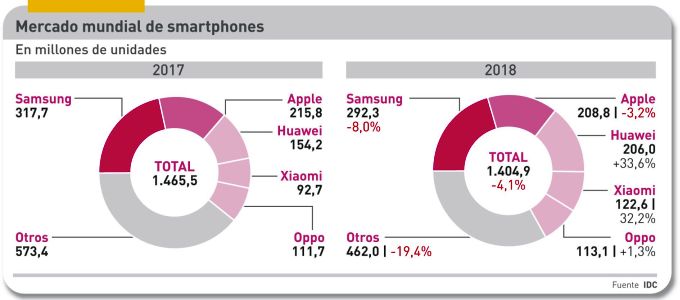

Primero se habló de desaceleración, luego de estancamiento para, al final, reconocer que estamos ante un retroceso en toda regla. Las ventas de smartphones han vuelto a caer tanto o más que en trimestres anteriores. Globalmente, el descenso ha sido del 4,1% en 2018 según IDC. En un mercado que absorbió 1.400 millones de unidades (uno por cada cinco terrícolas), el batacazo equivale a 65 millones. ¿Se ha acabado la era del crecimiento? ¿Hay algo que la industria pueda hacer para revertir la tendencia?

Hay varias explicaciones de lo que pasa pero ninguna es verdaderamente nueva. Los consumidores desoyen los mensajes de marketing y alargan el ciclo de sustitución tanto como pueden porque el móvil que llevan consigo les satisface. Es sencillo comprobar que cuanto más enfático sea un lanzamiento, más probable es que esconda escasa innovación. En paralelo, los usuarios se quejan de que en lugar de bajar de precio – como a ellos les gustaría – los nuevos smartphones son cada vez más caros.

Hay que contar con otro hecho: en la estadística global influye que los mercados menos maduros – salvo excepciones como India, Indonesia o Vietnam – están al borde del nivel de saturación que aqueja a los países ricos. Hecha esta salvedad, la madre de los problemas es China que representa el 30% del mercado mundial y cuyo bajón oscila entre el 10%, según distintas consultoras.

A escala mundial, las cinco marcas líderes incrementan su cuota conjunta: el 69% contra el 63% en 2017. Si en la lista se incluye a la fluctuante Vivo, el sexteto suma el 75%. Poco o muy poco queda para algunas marcas, antes célebres, reducidas a un papel marginal.

Vuelvo al precio, que me parece asunto crucial. La industria pretende que los consumidores hagan lo que a ella le conviene: pagar más por dispositivos que casi no aportan innovaciones. ¿Por qué tendrían que hacer con los smartphones algo distinto a lo que hacen con los PC, los coches o los guisantes congelados?

Esta es la razón por la que algunos análisis se vuelcan en las categorías, así llamadas premium [por encima de 400 dólares], que en 2018 habrían crecido un 18% mientras la gama de menos de 200 dólares perdía un 10%, dando como balance la caída global apuntada. Según Counterpoint Research, fuente de ese cálculo, Apple sería la marca dominante (51%) del segmento premium, seguida de Samsung (22%) y Huawei (10%); el restante 17% se reparte entre otros fabricantes entre los que destacan LG y el emergente OnePlus.

Ahora bien, cuando los dispositivos premium se desglosan en asequibles (400/600), estándar (600/800) y ultrapremium (más de 800 dólares), uno descubre que el tramo superior es territorio de Apple (80%) y Samsung (20%).

En un contexto así de confuso, se entienden las tácticas de la industria. Por un lado, trata de elevar el precio medio innovando en pantallas, cámaras y chipsets que conllevan un aumento de sus costes. Por otro, de convencer a los consumidores sobre el mérito de pagar 700 dólares por un móvil premium asequible. Apple abrió el camino con el iPhone XR (ahora sugiere que habrá otro más barato) marcando el listón del Galaxy S10 que Samsung presentará los próximos días.

El cuarto trimestre, que incluye Black Friday y Navidades, no ha mejorado el panorama. La demanda ha caído un 4,9% al despacharse 20 millones menos que en el mismo período de 2017.

El delicado equilibrio del ranking parece a punto de romperse. En cifras anuales, Samsung mira más a Huawei que a su rival tradicional. Conserva un liderazgo gracias a que en el cuarto trimestre sólo perdió dos décimas de punto porcentual mientras Apple se dejaba 1,2 puntos. Pero la marca china pisa fuerte, con su impresionante 33,6% de incremento anual. Es cierto que ha vuelto a la tercera plaza (206 millones de smartphones en 2018) pero son sólo dos millones menos que Apple. Como es imaginable, la clave está en China, donde Apple ha caído al quinto puesto en volumen pero es líder en valor y Samsung prácticamente ya no cuenta.

Detrás vienen tres marcas chinas, cada una con más de 100 millones despachados. La cuarta plaza es de Xiaomi (+32,2%) seguida de Oppo y Vivo. El resto no identificado, que hace un año representaba un 40% del total, ha bajado al 32,9%. Todo parece indicar que la consolidación del mercado se acentuará.

En las próximas semanas se hablará mucho de innovaciones con mucho mérito: pantallas plegables, resoluciones más altas, cámaras y megapíxeles, cargadores rápidos y baterías más duraderas. Además de 5G, faltaría más. La incógnita está en cómo influirán sobre la frialdad (como mucho, tibieza) de la demanda.

31 de enero, 2019

cloud IBM Nick Head Vodafone

La noticia es que IBM y Vodafone han anunciado un acuerdo de colaboración para los próximos ocho años en el mercado cloud. A decir verdad, la anunció IBM unilateralmente, tal vez apremiada por la oportunidad de contarlo en la presentación de resultados de la semana siguiente que, por cierto, fue el primer año en positivo desde 2011. A lo que iba: si no recuerdo mal, esta es la segunda o la tercera vez que IBM y Vodafone abrazan iniciativas conjuntas, no con la misma ambición.

Puede decirse que el acuerdo tiene dos componentes: 1) IBM suministrará a la unidad B2B de Vodafone sus capacidades de cloud computing y 2) ambas crearán una estructura común para desarrollar tecnologías y soluciones que fusionen sus experiencias.

A falta de detalles, el primer componente no deja de ser un contrato de outsourcing con la finalidad explicita de dar soporte a los servicios gestionados que Vodafone vende a sus clientes corporativos. Como contrapartida de esa prestación, el grupo británico desembolsará 550 millones de dólares.

En principio, el primer beneficiario debería ser IBM al añadir un cliente / revendedor a su ´ecosistema` cloud, negocio que en 2018 creció sólo un 6% [5.700 millones de dólares]. Por parte de Vodafone, además de recortar los costes operativos de una actividad que requiere escala y cualidades que no necesariamente son las de una teleco, ganará acceso a los datacenter de IBM en países donde tiene poca presencia. Históricamente, tiene más afinidad con IBM que con cualquier otro proveedor cloud, un factor que no es desdeñable: anteriormente, el vínculo ha consistido en ofrecer servicios de hosting basados en tecnología de VMware soportados por IBM Cloud. Una experiencia útil, pero no suficiente.

El segundo componente es, a mi juicio, potencialmente más interesante, porque aspira a desarrollar soluciones que cubran huecos en la oferta de ambas partes del acuerdo. IBM y Vodafone no tienen prácticamente solapamiento, pero comparten un interés común en explorar las aplicaciones de 5G para el ámbito empresarial. Lo que sugiere que uno (Vodafone) aportará su experiencia en IoT y edge computing, mientras el otro contribuye con sus capacidades de datacenter, análisis de datos e inteligencia artificial. Se puede suponer que también el mayor conocimiento que IBM tiene de los sectores verticales.

Aunque se pinta como estratégico, el acuerdo tiene un evidente sabor comercial. Según ha informado IBM, empezarán por la captación de un puñado de empresas (early adopter) con las que serán identificados los posibles servicios. Luego, al desarrollarlos, podría aparecer el riesgo de “choques culturales”, entre dos organizaciones articuladas. Quizás sea una de las razones por las que el acuerdo se materializará en un joint venture legal y físicamente separado, dirigido paritariamente.

Se plantea así un asunto que puede ser delicado: el acuerdo prevé la transferencia de empleados de Vodafone (oficiosamente, 750) a la nueva empresa conjunta. El anuncio ha coincidido con la salida del director de cloud y automatización del grupo británico, que ha sido inmediatamente fichado por Nokia.

Ante el desfallecimiento de los ingresos por servicios de movilidad, todos los operadores asignan creciente importancia a sus negocios B2B, por lo que la aproximación a las empresas es crucial para ellos. Y para esa aproximación necesitan contar con una propuesta cloud consistente. La experiencia de Vodafone parece indicar que no ha tenido un impacto real en un mercado cuya hegemonía parece prematuramente adjudicada.

Si bien IBM es un competidor menor en el segmento IaaS, no se conforma. Cloud computing es uno de sus “imperativos estratégicos” y, tras la compra de RedHat, dispondrá de un instrumento para insertarse en la competencia, que se agudiza, en torno al concepto multicloud. Esta es la carta que ha jugado Nick Head, nuevo CEO de Vodafone, tras constatar que ser un competidor aislado deja magros frutos. No descartemos que sirva de lección a otras telecos europeas, pero no es el momento de señalar a nadie.

29 de enero, 2019

Dell Michael Dell Pat Gelsinger SilverLake VMware

Al ver imágenes de Michael Dell en Davos encabezando la oposición a la iniciativa de una congresista estadounidense que propone un impuesto “a los muy ricos”, he recordado el incumplimiento de mi promesa de comentar en este newsletter el retorno a bolsa de Dell Technologies, consumado el pasado 28 de diciembre tras cinco años de ausencia.

En Davos, precisamente, Michael Dell declaraba que “durante el período en que no cotizamos, transformamos profundamente la compañía. Actualmente, el 90% de nuestros ingenieros son especialistas en software. Los ingresos han crecido un 17% en los últimos nueve meses y nuestro negocio de datacenter ha crecido un 22%”.

Para la compañía [estoy harto de leer que fue fundada en el dormitorio de una residencia universitaria] la estrategia ha sido fructífera. El trimestre pasado arrojó un alza del 15% en sus ingresos y se espera que cierre 2019 con un rango de entre 90.500 y 92.000 millones de dólares.

Pero no es esto lo que pretendo comentar. Tras los decepcionantes días de regreso a Wall Street, Dell Technologies resulta ser uno de los muy raros casos en los que la capitalización bursátil de una empresa es inferior a la de las empresas (también cotizadas) que controla. Concretamente, a 45 dólares por acción, su valor en bolsa es de unos 34.000 millones de dólares, en tanto que la combinación de VMware (el 81%) y sus participaciones minoritarias en Pivotal Software y SecureWorks que suman 56.000 millones.

En noviembre, el CEO de VMware, Pat Gelsinger, decía confiar en que el desenlace de la operación pondría de relieve el valor de la empresa que dirige. Así ha sido: la discrepancia de valor entre Dell y VMware obligó en diciembre a Michael Dell a subir su oferta por las acciones de transición (DVMT), supuestamente alineadas con las de su participada. Desde entonces, la cotización de Dell se ha estancado por debajo del precio de salida, mientras la de VMware ha aumentado un 10% durante este lapso de tiempo.

Los analistas sostienen que a su precio actual la acción de Dell está barata y supongo que tendrán razón. Por ejemplo, Jim Suva, de Citigroup, la califica de “muy atractiva” y augura un gran salto en sus beneficios del segundo semestre de 2019 [durante el primero, prevé, tendrá que enjugar costes derivados de la consolidación].

A lo que quiero llegar es a que Michael Dell y sus socios de SilverLake controlan el 73% del valor de Dell [55% y 18% respectivamente] pero asumen la mayor carga de la deuda comprometida en 2015 para comprar EMC en 67.000 millones de dólares. Quienes han echado cuentas calculan que esta “fusión inversa” (sic) les habría aportado como premio unos 10.000 millones de valor sustraído a los poseedores de acciones DVMT. Es normal que los damnificados se venguen depreciando las acciones de Dell que han recibido a cambio de las DVMT.

La agencia Bloomberg, en su Billionaires Index, atribuye a Michael Dell una fortuna de 27.000 millones de dólares, que ha acumulado partiendo de los 15.000 millones de 2013, año en que inició su maniobra de ingeniería financiera. ¿Puedo concluir que hoy es 12.000 millones más rico que hace cinco años? En ese caso, no me extraña su hostilidad hacia un impuesto que tiene cero posibilidades de ser aprobado.

23 de enero, 2019

Bob Swan Brian Krzanich Diane Bryant Intel Jim Anderson John Srouji Navin Shenoy Reneé James Venkata Renduchintala

Mañana jueves, Intel presentará sus resultados del año fiscal 2018. Según la agencia Bloomberg, aprovecharía la ocasión para anunciar – tal vez unas horas antes – el nombre del sucesor o sucesora de su anterior CEO, Brian Krzanich, forzado a dimitir hace siete meses con un pretexto pueril. No soy quien para especular sobre las supuestas candidaturas que se barajan, pero es un juego entretenido.

Básicamente, el consejo de Intel [en el que, extrañamente sólo hay un experto en semiconductores y es un académico] se enfrenta a un par de dilemas. El primero – promoción interna o fichaje externo – asume como variante alguien que habiendo sido directivo de la compañía se haya marchado por discrepancias con Krzanich. El segundo dilema – hombre o mujer – se superpone al primero, pero a Intel no se le puede reprochar falta de diversidad: un 28,8% de su plantilla y un 19,4% de sus puestos de dirección están ocupados por mujeres.

La gran pregunta debería ser qué cualidades hay que reunir para dirigir la empresa más prominente de una industria global que factura 400.000 millones de dólares. ¿Alguien capaz de enderezar el rumbo industrial? ¿Alguien con talento y talante para reforzar el prestigio de la marca?

O los dos atributos, si fuera posible. Vaya usted a saber quién habrá presentado ante el consejo el modelo de negocio más convincente. Por cierto, no tengo muy claro cuál es el modelo de negocio actual de Intel, aparte de defender sus murallas.

Para empezar, Bob Swan, CFO y CEO en funciones, no aspira a seguir en el puesto [aunque quizá se dejaría convencer en el extremo caso de bloqueo]. Un candidato ´natural` que se desmarcó sin correr es Pat Gelsinger, cómodo en su condición de CEO de VMware. Veamos cómo gira la rueda de los nombres.

Históricamente, Intel ha preferido la promoción interna, pero Kraznich se ocupó de purgar a cualquiera del que sospechara ambiciones sucesorias. Uno que parecía no tenerlas es ahora el primer candidato (presuntamente): Venkata (Murthy) Renduchintala, procedente de Qualcomm y actualmente chief engineering officer de Intel. Suena como ganador en las quinielas, pero puede tener un serio competidor en Navin Shenoy, VP y director general del Data Center Group, quien antes dirigió el Client Computing Group, de modo que tiene un conocimiento directo de las dos grandes fuentes de ingresos de la compañía. Además, fue durante tres años jefe de gabinete del antiguo CEO Paul Otellini.

Propensos a especular, algunos medios han lanzado hipótesis de fichajes improbables, como Lisa Su, CEO de AMD, o Cristiano Amon, presidente de Qualcomm, dos grandes rivales de Intel.

De las (supuestas) candidaturas externas, tiene buena pinta la de John Srouji, VP de hardware de Apple – y máximo responsable del diseño de los procesadores de la serie A – quien no carece de antecedentes en Intel, ya que en los 90 trabajó en su centro de I+D de Israel. Estos días se ha hablado de un “tapado”, Jim Anderson – otro ex empleado de Intel – quien actualmente es CEO de Lattice Semiconductor.

Son imaginables las reacciones que provocaría la elección de un CEO de fuera, pero tal vez la solución estaría en lograr el retorno de una de dos damas que serían bien recibidas. Una es Diane Bryant, celebrada durante sus años al frente del Data Center Group y la otra, Renée James, quien dejó un buen recuerdo como número dos inicial de Krzanich. Las dos son, por lo que me consta, excelentes comunicadoras.

El prolífico articulista Rob Enderle ha escrito que, según sus fuentes, “el consejo de Intel estaría dividido entre los partidarios de Murthy y de emular la estrategia de Qualcomm (sic) y quienes se oponen con el argumento de que no ha sido capaz de restaurar el liderazgo industrial perdido”. Pronto lo sabremos, vale, pero por una quería sentir el gustillo de contar algo antes de que ocurra.

17 de enero, 2019

CES China CTA Donald Trump Gary Shapiro. GfK GSMA

El CES de este año ha sido tan concurrido como los anteriores: 180.000 personas asistieron a una feria con los rasgos de cambalache que se le suponen. La ratio de supervivencia de las novedades que se exponen sigue bajando: alguien ha calculado que sólo tres de cada diez llegan durante el año al mercado. En esto, el CES 2019 no ha cambiado, pero se comprende que el discurso inaugural de Gary Shapiro, CEO de la CTA, entidad organizadora incluyera esta advertencia: “Los aranceles [contra las importaciones desde China] están haciendo daño a nuestra economía al funcionar como auténticos impuestos a las empresas y los consumidores americanos”.

Así replicaba Shapiro a una reciente fanfarronada de Donald Trump, quien días antes había proclamado: “China nos está pagando una enorme cantidad de dinero en concepto de aranceles”. Shapiro fue más lejos aún, en lo que puede considerarse como la opinión oficial de la industria: reclamó que el gobierno de Estados Unidos adopte una política activa de innovación tecnológica en lugar de proseguir con su actitud restrictiva”.

No puedo menos que relacionar este pronunciamiento con la deserción de expositores chinos, cuyo número ha bajado un 20% con respecto al año pasado: de 1.551 a 1.211. Es sabido que esas empresas acuden al CES en busca de socios, revendedores y distribuidores en el mercado estadounidense, pero las amenazas que pesan sobre el comercio entre los dos países resulta claramente disuasoria.

Como es habitual, la CTA publica cada año un análisis de tendencias del mercado estadounidense. Según su proyección, el sector de la electrónica de consumo [cuyo perímetro es cada vez más difuso] alcanzará en 2019 una facturación de 301.000 millones de dólares al por mayor y de 398.000 millones a nivel minorista. Según Steve Koenig, su responsable de estudios, “el futuro se presenta brillante para muchos de los productos que los consumidores conocen [smartphones, laptops y televisores] gracias a que la industria sigue innovando en ellos”. Además, dijo, “2019 será el año de introducción de los primeros dispositivos 5G y de llegada de la nueva generación de televisores 8K, pero sobre todo se caracterizará por una evolución de los contenidos y la mejora de la experiencia de los consumidores a través de las tres pantallas; esto elevará sustancialmente el gasto en tecnología”.

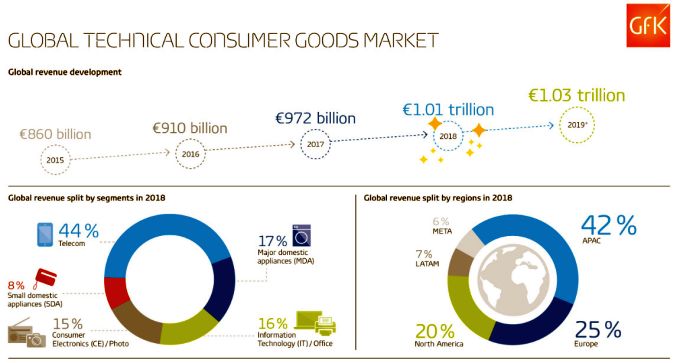

Por su lado, la consultora GfK siempre aprovecha la ocasión para presentar su exhaustivo análisis del mercado global que define como technical consumer goods (TCG) y que el año pasado excedió por primera vez el billón de euros, con un incremento del 4% sobre 2017. Los principales segmentos crecieron desigualmente: telecomunicaciones (+7%), electrónica y fotografía (+6%), IT y equipos de oficina (+1%), pequeños electrodomésticos (+7%), pero los grandes electrodomésticos flaquearon (1%). A destacar el desglose regional: Asia Pacífico aportó el 42% de las ventas totales, dejando un 25% para Europa y el 20% para América del Norte.

“Como grandes tendencias globales, observamos una mayor demanda de productos premium en prácticamente todos los segmentos del mercado – comenta GfK – y que los consumidores asignan más valor a la conectividad y la conveniencia que al precio”. Basándose en esto, la consultora se aventura a estimar que en 2019 el mercado TCG crecerá un 2%, es decir la mitad que el año pasado.