Meticulosamente calculado, como todo lo que hace Apple, la actualización de su política de privacidad ha despertado suspicacias. Por bien intencionada que fuera, la incorporación en sus sistemas operativos de una herramienta de detección automática de pornografía infantil ha sido criticada por activistas e incluso empleados de la compañía, que ven un subterfugio tras la apariencia ética de la medida. Por su lado, las autoridades estadounidenses la celebran como una revisión de la supuesta tolerancia de Apple hacia los usos delictivos de sus dispositivos. En todo caso, el episodio pone en evidencia que Apple tiene capacidad bastante para vigilar desde la trastienda lo que hacen los usuarios.

Esta nueva función en los terminales que funcionan bajo iOS15, iPad15, watchOS 8 y MacOS12, se presenta como respuesta a un reclamo social, la lucha contra la proliferación de imágenes de contenido sexual explícito protagonizadas por menores. Lo que ha levantado sospechas porque contrasta con la política tradicional de negarse a las peticiones policiales de desbloqueo de sus iPhones, con el argumento de que ni ella misma podría hacerlo.

La sospecha no es nueva. Un precedente que habla en favor de Apple ha sido la investigación de la masacre de San Bernardino (a pocos kilómetros de San Francisco) en 2015 y del atentado contra una base aeronaval de Florida en 2019. En ambos casos, la compañía rehusó facilitar la tarea del FBI y este acabó contratando una compañía israelí para reventar la protección de los dispositivos. Si Apple desbloqueara un iPhone usado en actividades ilegales – dijo entonces Tim Cook, CEO de la compañía – los usuarios que no tienen nada que temer dejarían de confiar en la protección que les prometen.

Este verano, por primera vez, Apple ha definido la pornografía infantil como una “línea roja” que justifica una excepción en esa política. Los intereses de los niños están por encima de la laxitud que prevalece en Internet; los padres tienen derecho a confiar en el escudo protector de la marca. Sin embargo, durante años, la compañía californiana ha llevado su celo al extremo de hacer gala de su propia concepción como un valor que caracteriza a sus productos y servicios.

Anecdóticamente, en el CES de Las Vegas de 2019, Apple desplegó en la vía pública un enorme cartelón con el eslogan “Lo que ocurre en tu iPhone se queda en tu iPhone”, alusión al lema de la ciudad anfitriona, no por nada apodada Sin City. Los medios interpretaron aquel golpe de efecto como una bofetada a Google y su sistema operativo Android. Tim Cook ha proclamado en muchas ocasiones su compromiso con la privacidad de los usuarios y se ha enzarzado en agrias polémicas con Mark Zuckerberg. Sus alegaciones, bien dosificadas, le han servido para reforzar su oferta de servicios relacionados con la salud y las finanzas, entre otros una tarjeta de crédito (en colaboración con Goldman Sachs) que presume de inviolabilidad.

Aun así, los antecedentes explican la sorpresa ante el cambio de actitud. Varios gobiernos – y no sólo el estadounidense – presionan desde hace tiempo para que las compañías tecnológicas les proporcionen herramientas para descifrar sus dispositivos. Apple se niega a facilitar puertas traseras en su código para facilitar que los usuarios de sus dispositivos sean vigilados. Otras marcas son más transigentes cuando las llaman el FBI o sus equivalentes.

El mecanismo de seguridad contra la pornografía infantil, tal como fue anunciado a inicios de agosto, no afectará a todos los usuarios de iPhone, sino sólo a los de su última release del sistema operativo y exclusivamente en Estados Unidos. Lo que no obsta para que el asunto adquiera dimensión global.

El primer cambio concierne a la función Messages, al permitir el escaneo de las fotos adjuntas para identificar cuáles son explícitamente sexuales [CSMA, child sex abuse material] de manera que, si alguna de ellas es etiquetada como tal, Apple advierte al usuario de los riesgos en que podría incurrir si envía esa imagen. Si el usuario tiene menos de 13 años, notificará a sus padres, a menos que estos hayan cancelado voluntariamente esa opción, mientras que los mayores de 13 recibirán idéntica advertencia, pero no se informará de ello a su familia.

La segunda actualización concierne a los contenidos que están incluidos en la base de datos de una organización llamada NCMEC (National Center for Missing or Exploited Children), caso en el que se requerirá que haya coincidencia en 30 o más fotos objetables como condición para cerrar la cuenta de iCloud tras enviar un informe al NCMEC. En el tercer mecanismo, entra en juego Siri, el asistente digital automático de Apple, para ayudar a las autoridades en la búsqueda de depredadores sexuales.

La pornografía infantil, fenómeno abominable y cada vez más frecuente, no puede ser tomado a la ligera. Sólo en Estados Unidos, el número de imágenes y videos de esa naturaleza identificados en las redes durante la última década se ha multiplicado por nueve. En 2020 fueron denunciados 21,7 millones de casos los informes de transparencia publicados por las seis grandes redes sociales indican que entre 2018 y 2020 han eliminado cuatro veces más que en años anteriores. No hace falta decir que muchos de esos contenidos han sido creados, distribuidos y consumidos utilizando productos de Apple.

No obstante, la decisión de escanear esos contenidos para advertir a los usuarios ha sido recibida con recelo por quienes opinan que podría servir de precedente para que en países con regímenes represivos, los gobiernos puedan exigir a Apple que emplee la misma tecnología para identificar y vigilar opositores. Una vez admitido públicamente que la tecnología lo permite, la compañía podría verse atrapada por su compromiso de cumplir las leyes de los países donde opera.

Además de mencionar a China, la Electronic Frontier Foundation (EFF) recuerda que la alianza conocida como Five Eyes – Australia, Canadá, Nueva Zelanda y Reino Unido, además de Estados Unidos – lleva años exigiendo que Apple y otras tecnológicas proporcionen acceso a redes cifradas para investigar actividades terroristas y delitos conexos.

En una entrevista con Wall Street Journal, Craig Federighi – vicepresidente senior de ingeniería de software de Apple – ha negado categóricamente esa posibilidad. El sistema desarrollado no constituye una puerta trasera ni en modo alguno es un antecedente para llevar su tecnología más allá de los alcances expresamente anunciados. Según Federighi, “la arquitectura que hemos desarrollado para identificar estos contenidos garantiza más privacidad que cualquier otro que se haya planteado hasta el momento, lo que es auditable y verificable […] Estoy en condiciones de asegurar que Apple no dará curso a ninguna exigencia para que esta tecnología suya se aplique a misiones de vigilancia”.

La fórmula adoptada por Apple, al mantener el cifrado de extremo a extremo, difiere de la escogida por otras compañías para el caso de recibir órdenes gubernamentales o judiciales.

La innovación a la que alude Federighi consiste en un software que no busca las fotos como tales sino su huella digital para definir patrones asociados a esas imágenes, reduciéndolas a hashes [literalmente, picadillo; técnicamente, fragmentos de algoritmo que condensan un mensaje]. Lo que este sistema tiene de particular a diferencia de un escaneado corriente, es que no se produce en la nube – en este caso, iCloud – sino en el propio dispositivo: la última generación de sus sistemas operativos lleva instalada una tecnología de machine learning que Apple denomina NeuralHash, a efectos de esa comparación.

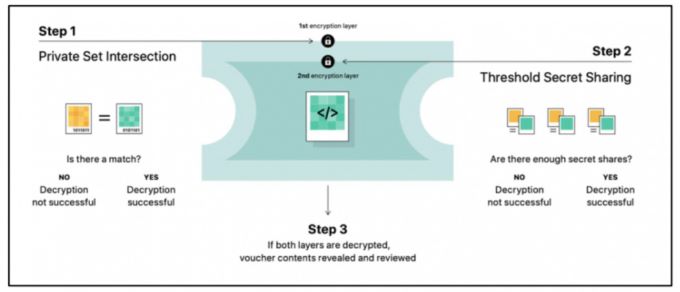

Según Erik Neuenschwander, director de privacidad de Apple, el algoritmo de generación y comparación trabaja bien incluso cuando dos imágenes no son exactamente iguales. La tecnología es capaz de identificar como una misma foto dos versiones recortadas, con calidades diferentes o niveles de color distintos. Antes de que el usuario suba a iCloud una imagen, su dispositivo la convierte en una secuencia de hashes para su comparación. A esto, Apple la ha bautizado con una contorsión lingüística: Private Set Intersection (PSI). Cuando se produzca un cierto número de coincidencias, la compañía compartirá la información con el NCMEC y esta ONG la pondrá en conocimiento de las autoridades competentes.

Sólo cuando dos imágenes casen un determinado número de veces podrían ser visibles para su revisión manual por un equipo de Apple [esta ha calculado que la posibilidad de falsos positivos es de una entre un billón]. Aparte de la detección de imágenes, se ha creado la función iCloud Family, que da a los padres la opción de recibir un aviso de alerta si su hijo envía o recibe fotos en las que se detectan desnudos. Además, el sistema interviene si en un mensaje detecta palabras relacionadas con la explotación sexual infantil.

Tanto Federighi como Neuenschwander se han prodigado en explicar que el sistema no contempla dar acceso al contenido del usuario a través del sistema operativo. Las comprobaciones tienen lugar dentro del dispositivo porque el sistema operativo contiene – reducida a hashes no replicables – la base de datos del NCMEC. Por consiguiente, esta función no sería aplicable a otros tipos de búsquedas.

Pese a la insistencia de la compañía, los defensores de la privacidad en Internet se han movilizado: unas 8.000 personas y más de 90 asociaciones en Estados Unidos han firmado una carta abierta en la que alegan que esta nueva función dará alas a los gobiernos para pedir la ayuda de Apple en su violación de las libertades. Tim Cook puede esgrimir el precedente de San Bernardino, pero los críticos señalan que el gobierno chino ya tiene acceso a las cuentas de iCloud porque así lo dicta la legislación del país, que Apple no podría infringir en su caso.

Otras compañías tecnológicas se han involucrado en la polémica. En primer lugar, Facebook, que mantiene un largo contencioso con Apple a cuenta de la privacidad. Su filial WhatsApp se ha encargado de calificar el anuncio de Apple como “un sistema de vigilancia”. Al servicio de mensajería instantánea se le ha reclamado repetidamente que rompa su cifrado de extremo a extremo: uno de los países que lo ha hecho con más ahínco, India, ha aprobado una norma que, al menos formalmente, la obliga a rastrear el origen de los mensajes que sean calificados como ilegales.

Como en otros asuntos recientes, no se puede ignorar la influencia del ambiente enrarecido que rodea a las BigTech. Ante las acusaciones de monopolio que pesan sobre Apple, la compañía parece haber encontrado en la lucha contra la pornografía infantil una oportunidad de mostrar buena voluntad con el interés público y diferenciarse de otras que no han tenido los mismos reflejos.

[informe de Pablo G. Bejerano]