Big Data es sin duda uno de los grandes ejes por los que hoy circula la innovación en las TI [los otros, puede decirse, son cloud y analytics] y en el centro del debate acerca de cómo implementar esa estrategia vital se encuentra Hadoop. Pero… el problema es lo poco que se conoce acerca de este proyecto open source fuera de los círculos especializados. Se sabe que ha sido utilizado desde 2008 por grandes compañías de Internet – Google, Yahoo, Facebook, etc – para optimizar cargas de trabajo distribuyéndolas entre diversos conjuntos de ordenadores; era sólo el comienzo de la historia del elefantito amarillo: prácticamente toda la industria está hoy trabajando o interesada en Hadoop.

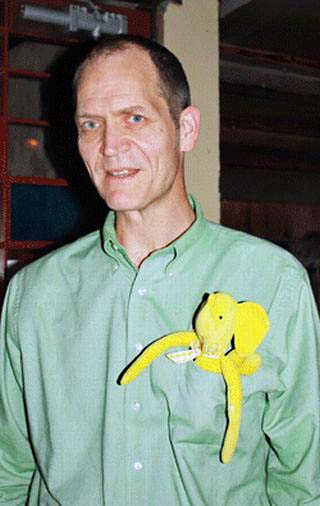

Apadrinado por Apache Software Foundation, el proyecto Hadoop tiene su raíz en un paper escrito en 2004 por Doug Cutting (foto), a la sazón ingeniero de Google, en el que describía las técnicas para ´mapear` un problema de manejo de datos voluminosos en sucesivos subproblemas, para distribuirlos entre decenas o cientos de nodos, y luego combinarlos en un conjunto reducido y fácil de analizar.

A finales de marzo, el autor de este blog tuvo ocasión de conversar con Cutting, el “inventor” de Hadoop. Según su relato, la prehistoria de este se remonta a sus tiempos de Google [disconforme con ciertos condicionamientos, acabó por marcharse a Yahoo, donde continuó con su desarrollo hasta concretarlo en 2008]. ¿Por qué el logo de Hadoop? Como quiere la costumbre, decidió bautizar su criatura, y lo hizo con el nombre que su hijo de 3 años daba a su mascota, un elefante amarillo de peluche.

Doug Cutting es un tipo entrañable y modesto, que trabaja como arquitecto de software de Cloudera, cuya distribución de Hadoop lidera el mercado y ha reclutado expertos de casi todo el espectro del Silicon Valley: el CEO viene de Oracle, el chief scientist de Facebook y el CTO de Yahoo. Como es habitual en las compañías de open source, Cloudera presta servicios de formación, soporte y vende herramientas para la gestión en cluster. Su distribución de Hadoop, y el gestor básico, son gratuitos para clusters de hasta 50 máquinas.

Si Big Data es, como dicen, una revolución, Hadoop sería una de las armas de esa revolución. La era comercial ha comenzado en 2011. Los tres grandes proveedores de bases de datos (Oracle, IBM, Microsoft) ya han adoptado Hadoop. ¿Llegará a ser tan importante como SQL? A menudo se ha definido a Hadoop como una tecnología para el tratamiento de datos no estructurados, Cutting corrige esta idea corriente: la combinación de escalabilidad, flexibilidad y bajo coste, hace que pueda aplicarse a todo tipo de datos, más allá de sus orígenes. Oracle recientemente llegó a un acuerdo con Cloudera para incorporar su distribución en su appliance analítico.

Otras dos empresas destacan en esta nueva galaxia: MapR – cuyo equipo acarrea experiencias de EMC, Microsoft y Cisco – y Hortoworks, cuya filiación se remonta claramente a Yahoo, de la que se separó en 2010. El cuarto competidor, en un plano diferente, es EMC, que asocia su oferta Big Data producto de su filial Isilon con el software de Greenplum, adquirida el año pasado.

El mayor obstáculo que debe superar Hadoop deriva de su origen. Como producto de la comunidad open source, es visto con suspicacia en muchos departamentos de TI. Contradictoriamente, esto ocurre por su potencial de reducir las inversiones en tecnologías ´propietarias` asentadas. Ha dado prueba de sus virtudes como sustrato de Internet y las redes sociales, pero aún tiene que ser aceptado como herramienta estándar en las empresas, que se espera ocurra a cubierto del concepto Big Data.

“Hadoop es una gran plataforma para almacenar y procesar grandes volúmenes de datos, pero necesita más aplicaciones analíticas para alcanzar una masa crítica […], la killer application aún no ha aparecido”, reconoce Amr Awadallah, CTO de Cloudera, sentado a la mesa junto con Cutting

La industria anda alborotada con el elefante amarillo. Además de la iniciativa de Oracle – que, como es usual, ha dado pie a especulaciones sobre una eventual oferta – también Microsoft ha introducido Hadoop en su servicio cloud Azure, pero por el momento supedita su lanzamiento a la disponibilidad final de la distribución que ha escogido, Hortonworks, todavía incompleta. IBM ha empaquetado Hadoop en su herramienta de análisis de datos InfoSphere. Los fabricantes de servidores, que tratan de capitalizar la escalabilidad de Hadoop. Un ejemplo es Cisco, que predica su adopción de este software en congruencia con sus acuerdos con EMC.

Se hace imprescindible un resumen. Concebido dentro de la comunidad open source – Doug Cutting preside actualmente el consejo de la fundación Apache – Hadoop se ha asomado al mercado como una solución para los problemas planteados por lo que ha dado en llamarse Big Data. Se espera que en los próximos 18 meses, las grandes compañías que experimentan con este software presenten novedades y anuncien los primeros despliegues comerciales.