Newsletter

12 de enero, 2021

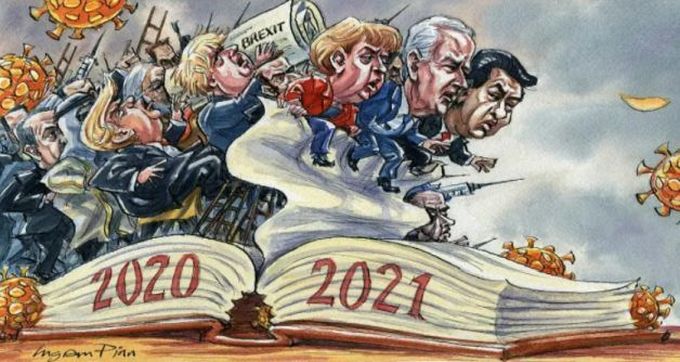

Angela Merkel Brexit China ciberseguridad. Covid-19 Donald Trump Joe Biden

© Ingram Pinn / Financial Times

Tras el año del coronavirus, llega el año de las vacunas, bienvenidas sean. Al iracundo Trump le sucederá la templanza de Biden. Y una vez consumado el Brexit, las partes han pactado una transición que evita causar más daños en la relación entre Reino Unido y sus antiguos socios. Por su lado, sin apearse de su autoritarismo, Xi Jinping ha cerrado un acuerdo sobre inversiones con la Unión Europea que pretende servir de modelo para el alivio de la confrontación con Estados Unidos. Imaginará el lector por qué empiezo 2021 ocupándome de estas cuatro capas del contexto que va a condicionará la vida de un sector que, con demasiada frecuencia, tiende a mirar sólo su ombligo (digital, por ser cortés).

26 de noviembre, 2020

5G Boris Johnson Donald Trump Huawei Open RAN Víctor Zhang

Hubo un momento, a finales de enero, en el que Boris Johnson amagó con ponerse de perfil ante las presiones que recibía desde Washington y creyó posible dejar en manos de los operadores británicos la decisión final acerca de sus despliegue de redes 5G. Las advertencias de estos sobre los costes que tendría para el país sumarse al boicot promovido por Donald Trump parecían haber surtido efecto. Grave error de diagnóstico: diez meses después, Johnson ha enviado a los Comunes un proyecto de ley cuyo objetivo explícito es expulsar a Huawei del Reino Unido, un viraje intervencionista que revisa la decisión anterior de limitar la presencia del fabricante chino a una tercera parte del mercado. Leer más

10 de noviembre, 2020

China Donald Trump Facebook Google Huawei Joe Biden Kamala Harris Paul Triolo

Sería imperdonable no abrir la semana con un par de comentarios acerca del cambio drástico en la política estadounidense y sus consecuencias previsibles, tras los desastrosos cuatro años de Donald Trump. El triunfo de Joe Biden ha sido recibido con alivio por la industria de la tecnología, protagonista de este blog. Sin embargo, se equivocarían los ejecutivos de Silicon Valley si esperasen tener con Joe Biden una relación de complicidad parecida a la que disfrutaron con Barack Obama, tal como explica Richard Waters, corresponsal del FT en San Francisco. Antes de entrar en esas consideraciones, habrá que despejar la última incógnita pendiente hasta el 5 de enero: qué partido controlará el Senado. Leer más

21 de agosto, 2020

Alphabet Amazon Apple Facebook iPhone Microsoft Tim Cook Wall Street

El récord de Apple ha durado sólo unas horas, pero volverá a repuntar en los próximos días. Su valor bursátil de 2 billones de dólares es merecido. Lo incomprensible es que haya quienes – cronistas venales, por ejemplo – que lo celebran como si la noticia confirmase la teoría de una supuesta reactivación en V. La acción de la compañía de Cupertino se ha revalorizado un 54% desde la primera sesión del año, ensanchando la brecha que separa al grupo de líderes de Internet del resto de empresas de tecnología [Cisco, Dell, HPE, IBM, Oracle, en estancamiento crónico] y cada vez más divorciados de una economía mundial hundida en la recesión, ¿Qué deberíamos celebrar quienes no somos accionistas? Leer más

29 de julio, 2020

AMD Ann Kelleher Bob Swan Jim Keller Nvidia TSMC Venkata Renduchintala

Por lo visto, la importación de talento ajeno no es la fórmula idónea para resolver los problemas crónicos de Intel. La noticia de que Venkata (alias Murthy) Renduchintala dejará el lunes la compañía es la segunda parte de una noticia, según la cual el lanzamiento de los futuros chips con tecnología de 7 nanómetros queda postergado hasta finales de 2022 o comienzos de 2023. Procedente de Qualcomm, el fichaje de Murthy en febrero de 2016 produjo sensación por la cuota de mando que le confirió el entonces CEO, Brian Krzanich, en busca de un revulsivo que conservara para la compañía el liderazgo del mercado de semiconductores. Cuatro años después, Murthy se marcha habiendo perdido esa batalla. Leer más

25 de junio, 2020

Dell Technologies Michael Dell Nutanix Pat Gelsinger Silver Lake VMware

Es seguro que Michael Dell tiene preocupaciones que no confiesa, pero es evidente que en su cabeza no deja de darle vueltas a una idea recurrente: qué hacer con VMware. En 2016, cuando compró EMC a precio récord, dijo que la “joya de la corona” de su imperio sería esta subsidiaria, de la que pasaba a controlar el 81%. Lo sigue siendo, pero la última noticia es – según informa el Wall Street Journal – que Dell está considerando una nueva contorsión financiera apoyada en las acciones de VMware que controla. Supuestamente, el propósito sería elevar la cotización de Dell Technologies, que casi no se ha movido desde que retornó a bolsa en 2018. De momento, se ha disparado un 21% en 24 horas. Leer más

17 de junio, 2020

5G Jean-François Fallacher Laurent Paillassot Marie-Noelle Jégo Laveissiere MásMóvil Orange Stéphane Richard

Desconozco las razones por las que Laurent Paillassot deja de ser consejero delegado de Orange España y abandona la compañía. Lo digo de entrada, en respuesta a los lectores que me han preguntado. Además, en este newsletter de hoy me detendré sólo de pasada en la filial española del antiguo ´incumbente` francés. Hecha la advertencia, resulta llamativo que para sustituir a Paillassot – quien, por cierto, se expresa correctamente en español – Orange haya escogido a Jean-François Fallacher, hasta ahora responsable de su exitosa filial polaca, pero al parecer no ha encontrado a quién enviar a Varsovia.

Leer más

12 de junio, 2020

Apple ARM Intel iPad iPhone Mac TSMC

Con muy calculada antelación ha empezado a calentarse el ambiente previo al WWDC, evento anual de Apple para desarrolladores que este año tendrá que celebrarse online a partir del lunes 22. La gran novedad será el anuncio formal de que la próxima generación de Mac, en 2021, será equipada con un procesador de diseño propio basado en la arquitectura ARM, lo que implica renunciar a la x86 que la compañía viene usando desde 2006. Que el rumor de divorcio haya circulado durante años no obsta para que cuando llega el momento tenga consecuencias. Empezando por Intel, que se verá privada de entre el 2% y el 4% de sus ingresos además de sufrir daños en su reputación ante la industria y los usuarios. Leer más

10 de junio, 2020

Donald Trump Facebook Google Jack Dorsey Mark Zuckerberg Twitter

La simbiosis malsana entre Donald Trump y Twitter estaba condenada a acabar mal. No ha acabado todavía, porque el usuario más célebre de esa red (80 millones de seguidores) necesita ese altavoz para inflamar a sus partidarios. Si el vínculo de conveniencia ha empeorado, se debe a tres factores: la desastrosa gestión trumpiana de la pandemia, las protestas contra el racismo policial y lo que parece ser un giro de la campaña electoral que amenaza la reelección de Trump. Tras hacer la vista gorda durante años, Jack Dorsey, fundador de Twitter, ha tomado la iniciativa de refutar dos tuits presidenciales, en uno de los cuales se cuestionaba el voto por correo como supuesta fuente de fraude. Leer más

3 de junio, 2020

Apple GfK Huawei Samsung Smartphones Xiaomi

El alarmismo no es plato de gusto, pero no es tiempo de manjares. Poco a poco se van conociendo los destrozos de la pandemia en cada segmento del mercado. La crisis es global pero se manifiesta con crudeza en el mercado español de smartphones. Al cierre del primer trimestre, con quince días de estado de alarma, el mercado español había caído un 19,2%, ligeramente por debajo de los 2 millones de unidades vendidas. No sorprende, pero fue más grave que el 11,7% de bajada del mercado mundial. Un mes después, el acumulado cuatrimestral indicaba un descenso del 27,8% [2.240.000 unidades]. Me atrevo a sugerir que no ha sido un mal resultado, estando cerrada la mayoría de puntos de venta. Leer más

4 de mayo, 2020

Apple Canalys China Huawei IDC India Oppo Samsung Smartphones Strategy Analytics Vivo Xiaomi

Ha sido, sin paliativos, el peor trimestre desde la primera aparición de los smartphones. Y vendrán peores, démoslo por seguro. Según las cifras recopiladas por IDC, el mercado mundial declinó un 11,7%, con un total despachado de 275,8 millones de unidades. No hay razón de sorprenderse cuando el mercado chino, que absorbió más de una cuarta parte del total, cayó un 20,3%. Mientras tanto, en Europa y Estados Unidos, el descenso fue del 18,3% y 16,1% respectivamente.“Lo que empezó como un problema de oferta inicialmente limitado a China se ha convertido en una crisis de demanda global”, apunta la analista Nabila Popal, primera responsable del informe de IDC. Leer más

31 de marzo, 2020

Akamai DE-CIX Internet Orange Telefónica Teresa Bobis Vodafone

Una de las escasas buenas noticias que nos ha deparado marzo [sin duda son muchas más las malas] es esta: las redes de telecomunicaciones han aguantado el estrés provocado por la combinación de teletrabajo y confinamiento doméstico. Pese a los aviones en tierra, las fábricas cerradas y las ciudades bloqueadas, era de suponer que los datos – que el tópico define como la savia de toda economía moderna – fluirían en volúmenes crecientes asfixiando las infraestructuras. DE-CIX, uno de los mayores intercambiadores de tráfico IP de Europa, ha informado que su punto en Madrid ha experimentado en dos semanas sendas marcas históricas de transferencia de datos: el sábado 14 (468.30 Gbit/s) y el viernes 20 (494.74 Gbit/s). Leer más

17 de marzo, 2020

: economía BCE Christine Lagarde coronavirus Donald Trump FED Jerome Powell

Ya es tiempo de dedicar un newsletter a uno de esos comentarios económicos que me permito de vez en cuando y en estos días de aislamiento se me acumulan. Economistas de todas las procedencias e ideologías coinciden en valorar el comienzo de una recesión global. No hay necesidad de esperar estadísticas para corroborarlo. Sólo los que tienen responsabilidades institucionales se muestran más reservados en sus juicios. Gita Gopinath, economista jefe del FMI se ha atrevido un poco más: no estamos ante una recesión convencional – ha dicho – ni existen precedentes sobre cómo combatirla; “sólo una respuesta política adecuada podrá impedir que se transforme en una crisis financiera generalizada”. Leer más

6 de marzo, 2020

AMD Bob Swan George Davis Intel Morgan Stanley TSMC

Visto lo visto, el recurrente reproche de los fabricantes de PC a Intel por sus fallos de suministro acabará resultando casi lo de menos. Lo que hace más llevadero el reconocimiento por parte de George Davis, CFO de Intel, de que sus dificultades industriales van para largo. En una conferencia de Morgan Stanley, Davis aprovecho para hacer llegar un mensaje a los inversores: la compañía no alcanzará la paridad real con AMD mientras no logre poner en el mercado chips fabricados con proceso de 7 nanómetros, lo que significa esperar hasta finales de 2021. ¿Es una mala noticia? Sí, pero si se sirve con gotas de cinismo se concluye que Intel la digerirá sin daños severos a su negocio y su reputación. Leer más

5 de marzo, 2020

5G Borje Ekholm Ericsson Huawei Jorma Ollila Nokia Pekka Lundmark Rajeev Suri Sari Baldauf

La suerte de Rajeev Suri como CEO de Nokia quedó echada en octubre, cuando anunció a los accionistas la suspensión del dividendo para guardar liquidez con la que abordar nuevas inversiones en 5G. La cotización cayó el 23% en un día, pero los analistas habían avisado que los despliegues de los operadores – salvo excepciones – no estaban respondiendo a las expectativas. Era verdad: al cierre de 2019, los ingresos de Nokia cayeron sólo el 1% en moneda constante; escribo “sólo” debido a que a Suri le gusta separar las cifras de China de las del resto del mundo. No se trata de una tendencia exclusiva de la compañía finlandesa: algo similar podría decirse de otros, con la obvia excepción de Huawei. Leer más

2 de marzo, 2020

Carl Icahn Dion Weisler Enrique Lores HP John Visentin Steve Fieler Xerox

Lo que en primera instancia pudo ser un razonable proyecto de fusión pactada entre HP y Xerox, se ha enconado hasta rozar las tácticas más duras. Hoy, lunes 2, o en los próximos días, se conocerá un nuevo gesto de presión por parte de Xerox, que tratará de dirigirse directamente a los accionistas de HP ante el rechazo con que esta ha recibido su oferta de compra. La semana pasada, al presentar los resultados del primer trimestre de su año fiscal, Enrique Lores, CEO de HP, reiteró ese rechazo: para empezar, la ecuación de cambio propuesta falsea la realidad al aplicar al valor de HP un múltiplo de 7 veces la ratio precio/beneficio, mientras que atribuye a Xerox un múltiplo de 9,4. Leer más

17 de febrero, 2020

China Donald Trump GSMA Huawei John Hoffman John Strand

Es comprensible la decisión de la GSMA de cancelar el Mobile World Congress de la semana próxima. Le espera una cadena de litigios y reclamaciones de proveedores afectados por la medida. Este año perderá dinero y ni siquiera puede asegurar que mantendrá el MWC de Shanghai, convocado a finales de junio. Igualmente comprensible es que pretenda fundar su decisión en causas de fuerza mayor cuando la verdadera razón es económica, lo que no tiene nada de reprochable. Leer más

14 de febrero, 2020

Arista Networks Aruba Big Switch Cisco Dell Douglas Murray Jayshree Ullal Juniper Networks SDN VMware

A mediados del año pasado, Douglas Murray, CEO de Big Switch, declaraba que su negocio crecía “como la hierba”: desde 2015, un 80%, por lo que necesitaba reforzar su estructura comercial de los tiempos heroicos. Esto, para sacar pecho, pero era bastante conocido que la empresa – Murray o tal vez sus inversores – había llegado a la convicción de que su desarrollo independiente había llegado al límite y, por consiguiente, era hora de escuchar ofertas de compra. La lista de eventuales interesados, según el rumor, incluía a la crème de la crème del mercado de networking: Cisco, Juniper, Dell (y VMware), Extreme Networks, Arista Networks. Al final, Arista ganó la puja por una cuantía no revelada. La única referencia es que hace un año y medio, Big Switch era valorada en 350 millones de dólares. Leer más

22 de enero, 2020

Andrei Baranov AWS Azure backup Cohesity CommVault Insight Ventures Ratmir Timashev Veeam Software Veritas

Lamento no haberme ocupado más de ella durante demasiado tiempo. Hablo de Veeam Software, que ha sido una empresa europea de software, especializada en soluciones de backup y recuperación de datos. Lo escribo en pretérito, no porque haya desaparecido sino porque en pocas semanas dejará de ser europea al cerrarse su venta a la firma de inversión neoyorquina Insight Ventures, al goloso precio de 5.000 millones de dólares. La motivación más clara de esta transacción milmillonaria es una nueva intentona de disuadir la desconfianza del sector público de Estados Unidos a la hora de comprar software de una compañía cuyos fundadores, Ratmir Ratmir Timashev y Andrei Baronov, nacieron en Rusia. Leer más

Sobre el autor. Copyright © 2024 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons